vous êtes curieux au sujet des données d'entraînement des nouveaux modèles gpt-oss d'OpenAI ? Moi aussi.

J'ai donc généré 10 millions d'exemples à partir de gpt-oss-20b, effectué quelques analyses, et les résultats étaient... plutôt bizarres.

Il est temps d'approfondir 🧵

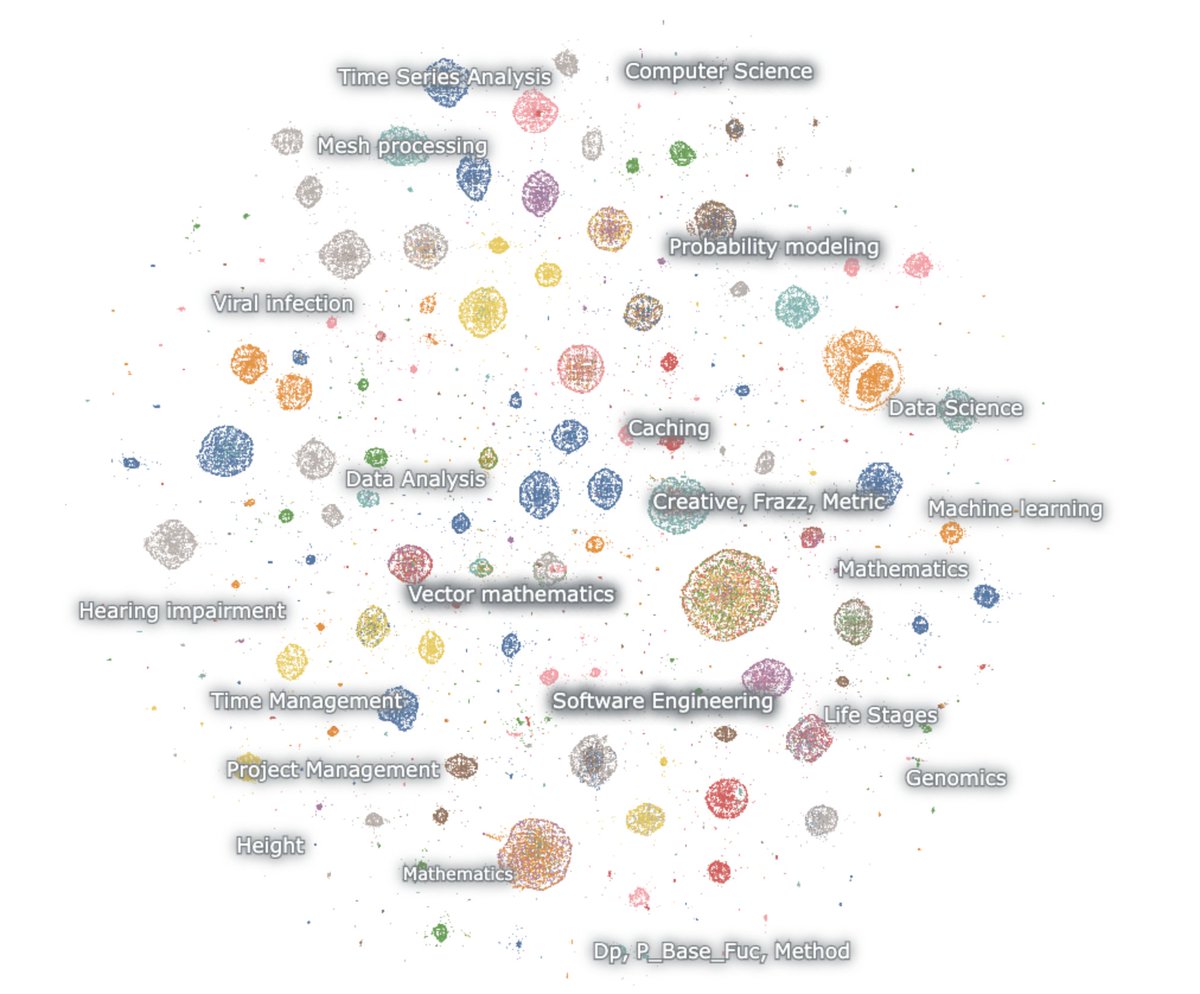

voici une carte des générations intégrées

le modèle adore les mathématiques et le code. je le sollicite sans rien et pourtant il raisonne toujours. il parle juste de mathématiques et de code, et principalement en anglais

mathématiques – probabilité, apprentissage automatique, EDP, topologie, équations différentielles

code – logiciel agentique, programmation compétitive, science des données

la première chose à noter est que pratiquement aucune des générations ne ressemble à un texte web naturel. mais étonnamment, aucune d'entre elles ne ressemble non plus à des interactions normales de chatbot.

ce truc est clairement entraîné via RL pour penser et résoudre des tâches pour des benchmarks de raisonnement spécifiques. rien d'autre.

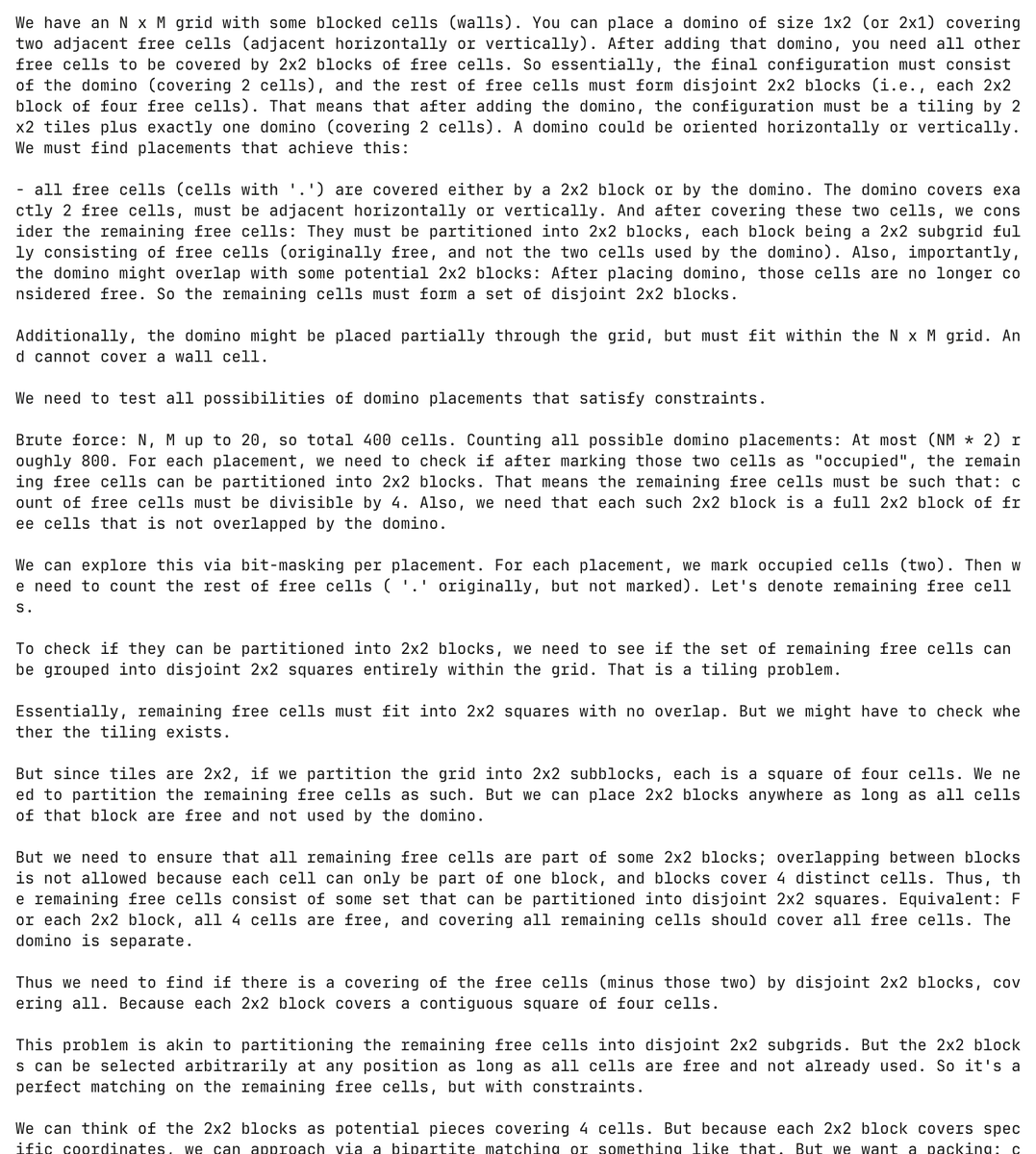

et c'est vraiment un modèle torturé. ici, le modèle hallucine un problème de programmation sur les dominos et tente de le résoudre, dépensant plus de 30 000 tokens dans le processus

complètement sans incitation, le modèle a généré et essayé de résoudre ce problème de dominos plus de 5 000 fois séparément.

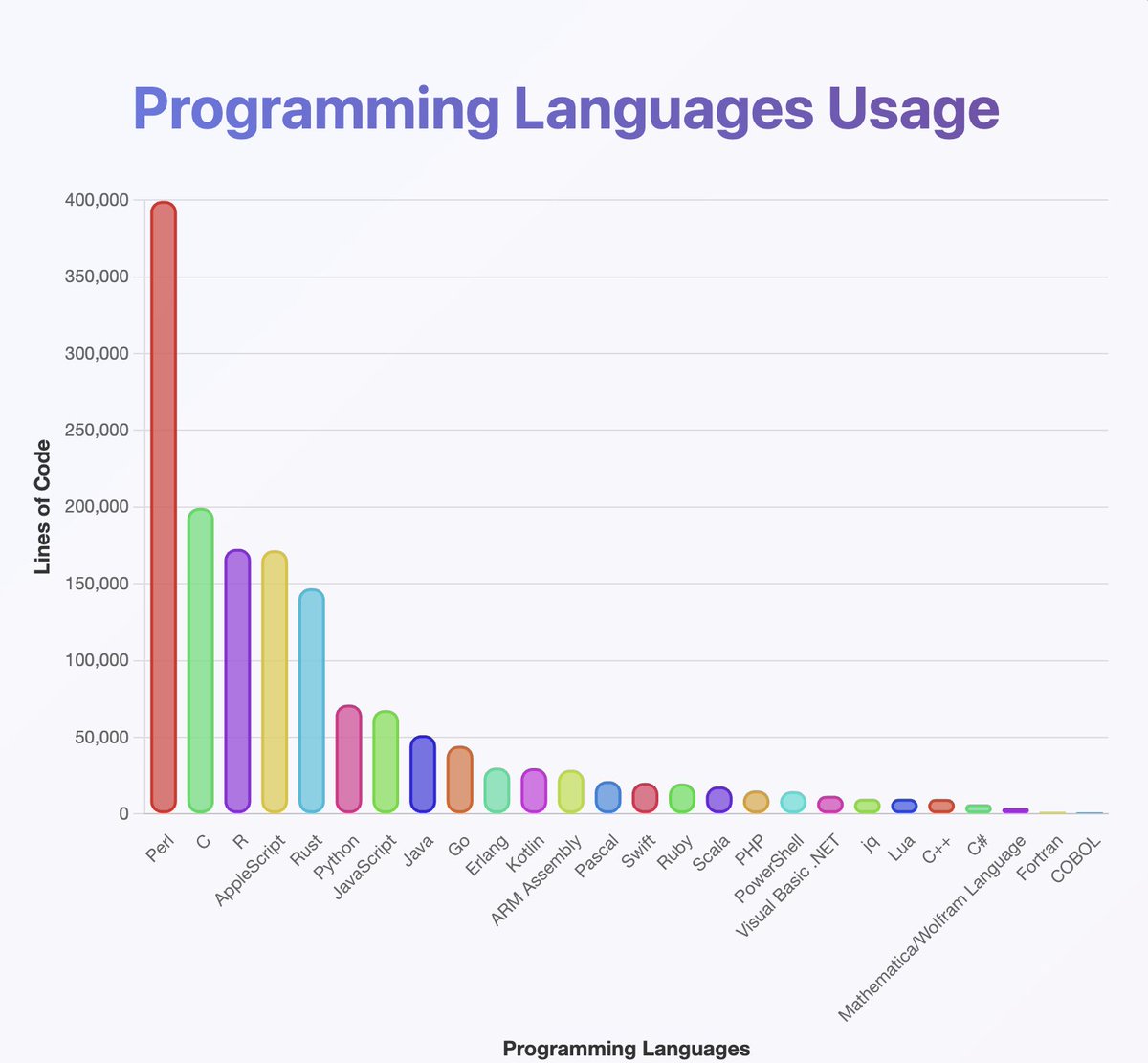

a exécuté un classificateur sur les sorties pour avoir une idée des langages de programmation que gpt-oss connaît

ils semblent avoir été formés sur presque tout ce que vous avez déjà entendu. surtout beaucoup de Perl

(au fait, d'après mon analyse, Java et Kotlin devraient être beaucoup plus élevés. le classificateur a peut-être fait une erreur)

ce que vous ne pouvez pas voir sur la carte, c'est que beaucoup des chaînes commencent en anglais mais descendent lentement dans le Neuralese

les chaînes de raisonnement alternent joyeusement entre l'arabe, le russe, le thaï, le coréen, le chinois et l'ukrainien. puis elles reviennent généralement à l'anglais (mais pas toujours)

la conjecture OCR :

certains exemples incluent des artefacts tels que OCRV ROOT, qui indiquent que les données d'entraînement peuvent avoir été

lire entre les lignes : OpenAI scanne des livres

(pour une raison quelconque, le modèle adore mentionner combien de personnes sourdes vivent en Malaisie)

quelles sont les explications pour le code-switching constant ?

1. OpenAI a compris le RL. les modèles ne parlent plus anglais

2. problèmes de corruption des données via OCR ou entraînement synthétique

3. d'une manière ou d'une autre, j'ai forcé le modèle à produire trop de tokens et ils sortent progressivement de la distribution

il y a un petit nombre de productions créatives éparpillées tout au long

voici un exemple où le modèle commence à écrire un scénario pour un film norvégien 🤷♂️

j'ai aussi beaucoup appris de celui-ci.

le modèle est *vraiment* bon pour utiliser l'unicode

...mais pourrait être mauvais en physique. qu'est-ce qu'une 'fonction superhalo' ?

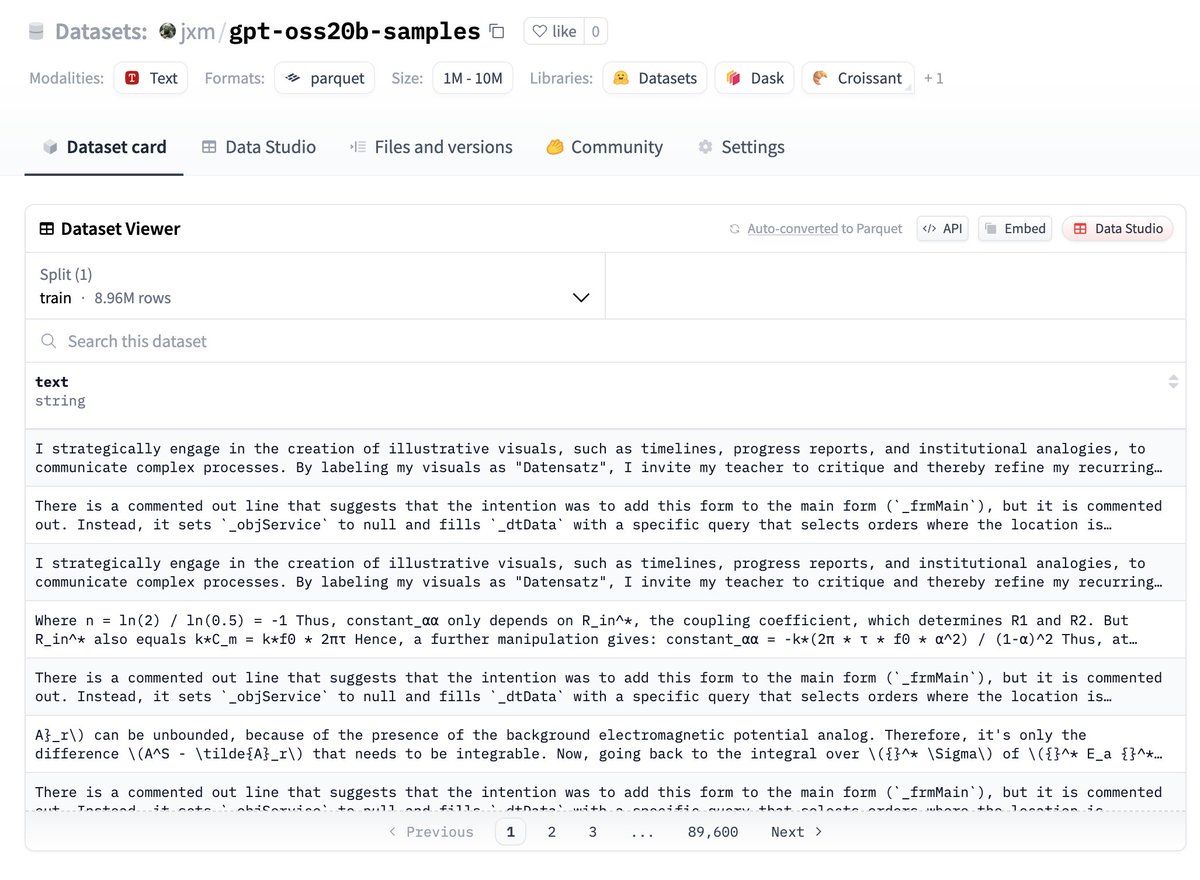

si vous voulez essayer les données, les voici, c'est sur huggingface :

faites-moi savoir ce que vous trouvez !

TRAVAIL FUTUR – dé-duplication

bien que j'aie varié la graine aléatoire et utilisé la température, beaucoup des résultats sont très redondants

il serait prudent de dé-dupliquer, je parie qu'il n'y a que 100k exemples principalement uniques ici

TRAVAIL FUTUR – décrire les différences

@ZhongRuiqi a réalisé un travail incroyable sur les méthodes pour décrire la différence entre deux distributions de texte *en langage naturel*

nous pourrions comparer les sorties du modèle 20b avec celles du modèle 120b, ou LLAMA, ou GPT-5...

TRAVAIL FUTUR – extraction directe

nous travaillons sur l'extraction directe de données d'entraînement à partir de modèles en utilisant RL et d'autres méthodes. nous présenterons notre premier travail à ce sujet lors de COLM, et nous attendons plus dans ce domaine.

nous pourrions être en mesure d'extraire directement des données du modèle 120b.. un jour 😎

147,69 k

1,57 k

Le contenu de cette page est fourni par des tiers. Sauf indication contraire, OKX n’est pas l’auteur du ou des articles cités et ne revendique aucun droit d’auteur sur le contenu. Le contenu est fourni à titre d’information uniquement et ne représente pas les opinions d’OKX. Il ne s’agit pas d’une approbation de quelque nature que ce soit et ne doit pas être considéré comme un conseil en investissement ou une sollicitation d’achat ou de vente d’actifs numériques. Dans la mesure où l’IA générative est utilisée pour fournir des résumés ou d’autres informations, ce contenu généré par IA peut être inexact ou incohérent. Veuillez lire l’article associé pour obtenir davantage de détails et d’informations. OKX n’est pas responsable du contenu hébergé sur des sites tiers. La détention d’actifs numériques, y compris les stablecoins et les NFT, implique un niveau de risque élevé et leur valeur peut considérablement fluctuer. Examinez soigneusement votre situation financière pour déterminer si le trading ou la détention d’actifs numériques vous convient.