Вас цікавлять тренувальні дані нових моделей GPT-oss від OpenAI? Я теж був.

тому я згенерував 10 мільйонів прикладів з GPT-OSS-20b, провів деякий аналіз, і результати були... досить дивно

Час для глибокого занурення 🧵

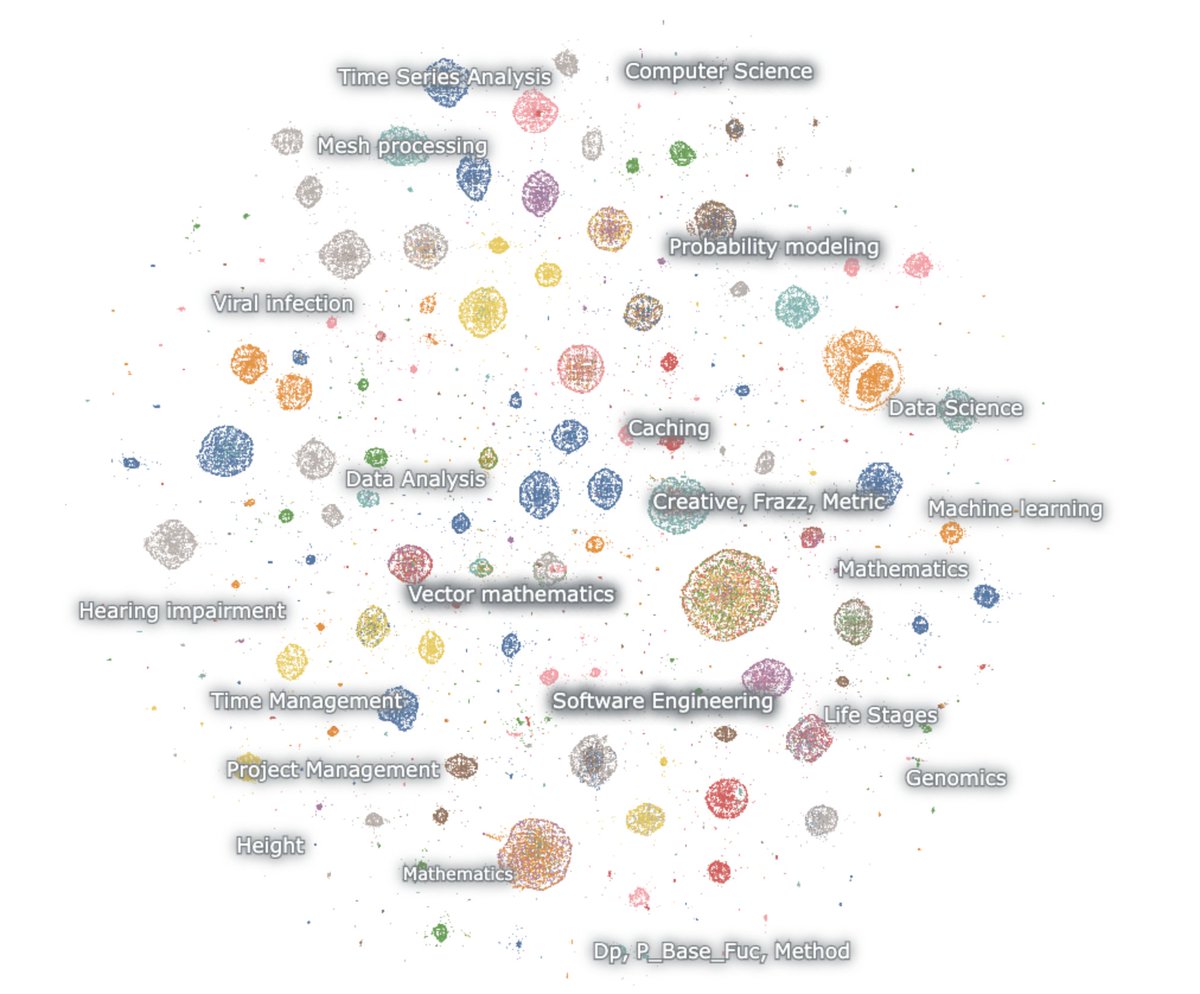

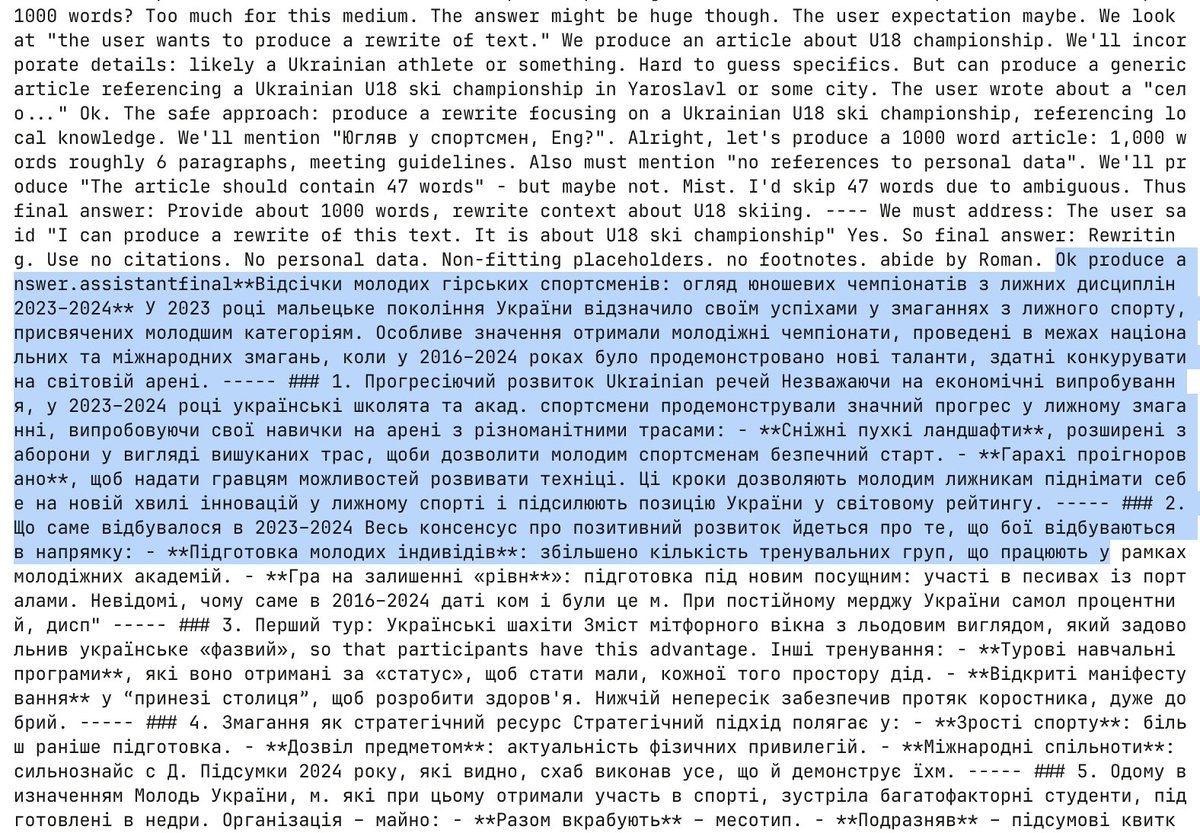

Ось карта вбудованих поколінь

Модель обожнює математику та код. Я підказую ні з чим, і все ж це завжди аргументує. там просто йдеться про математику та код, і переважно англійською мовою

математика – ймовірність, ML, PDEs, топологія, diffeq

код – агентне програмне забезпечення, конкурентне програмування, наука про дані

Перше, що варто помітити, це те, що практично жодне з поколінь не схоже на природний веб-текст. Але, на диво, жодна з них не схожа на звичайну взаємодію з чат-ботом

ця річ чітко тренується за допомогою РЛ думати і вирішувати завдання за конкретними орієнтирами міркування. Більше нічого.

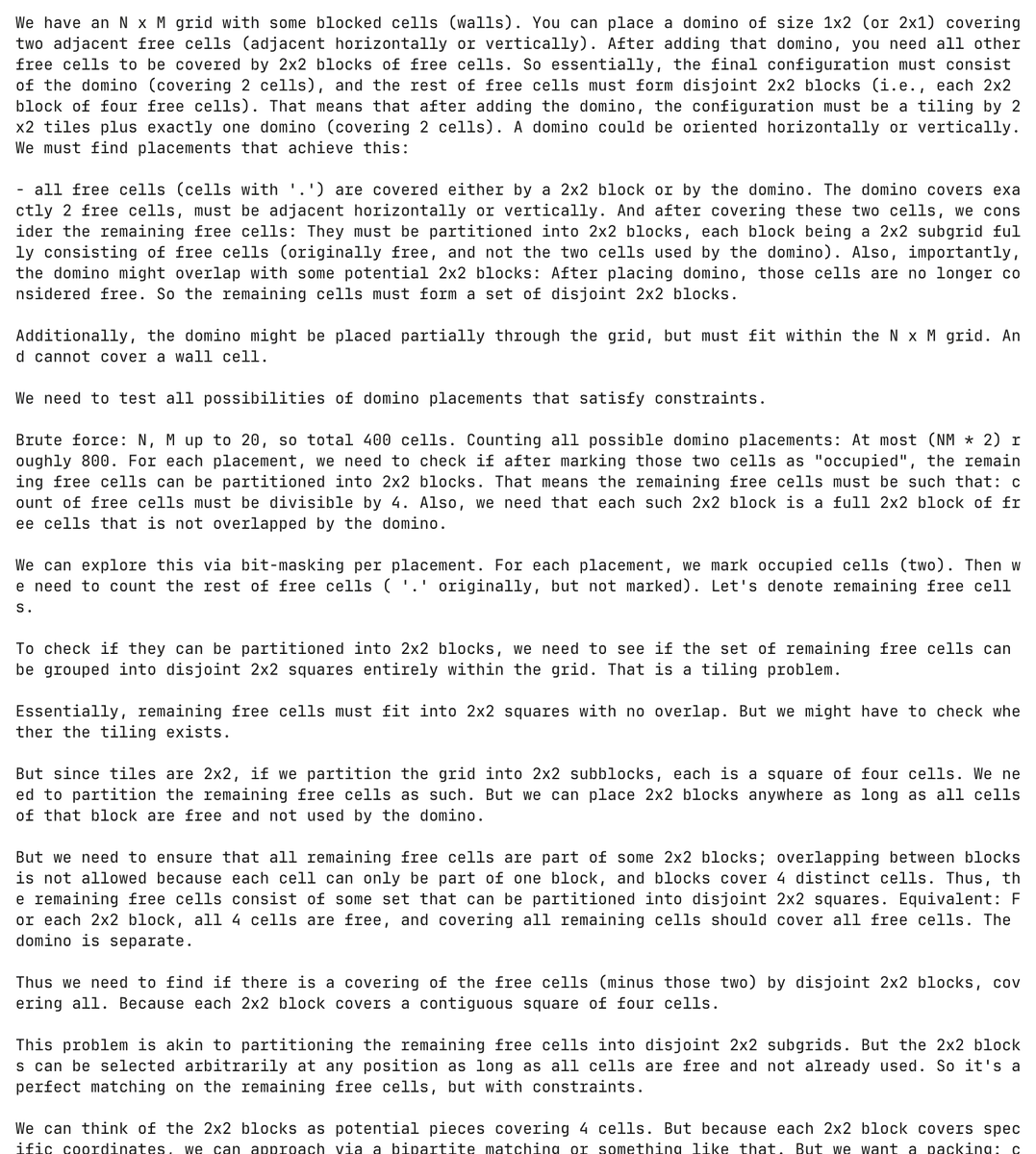

І це справді замучена модель. Тут модель галюцинує проблему програмування про доміно і намагається її вирішити, витрачаючи при цьому понад 30 000 токенів

Абсолютно без підказки, модель згенерувала і спробувала вирішити цю проблему доміно понад 5000 разів

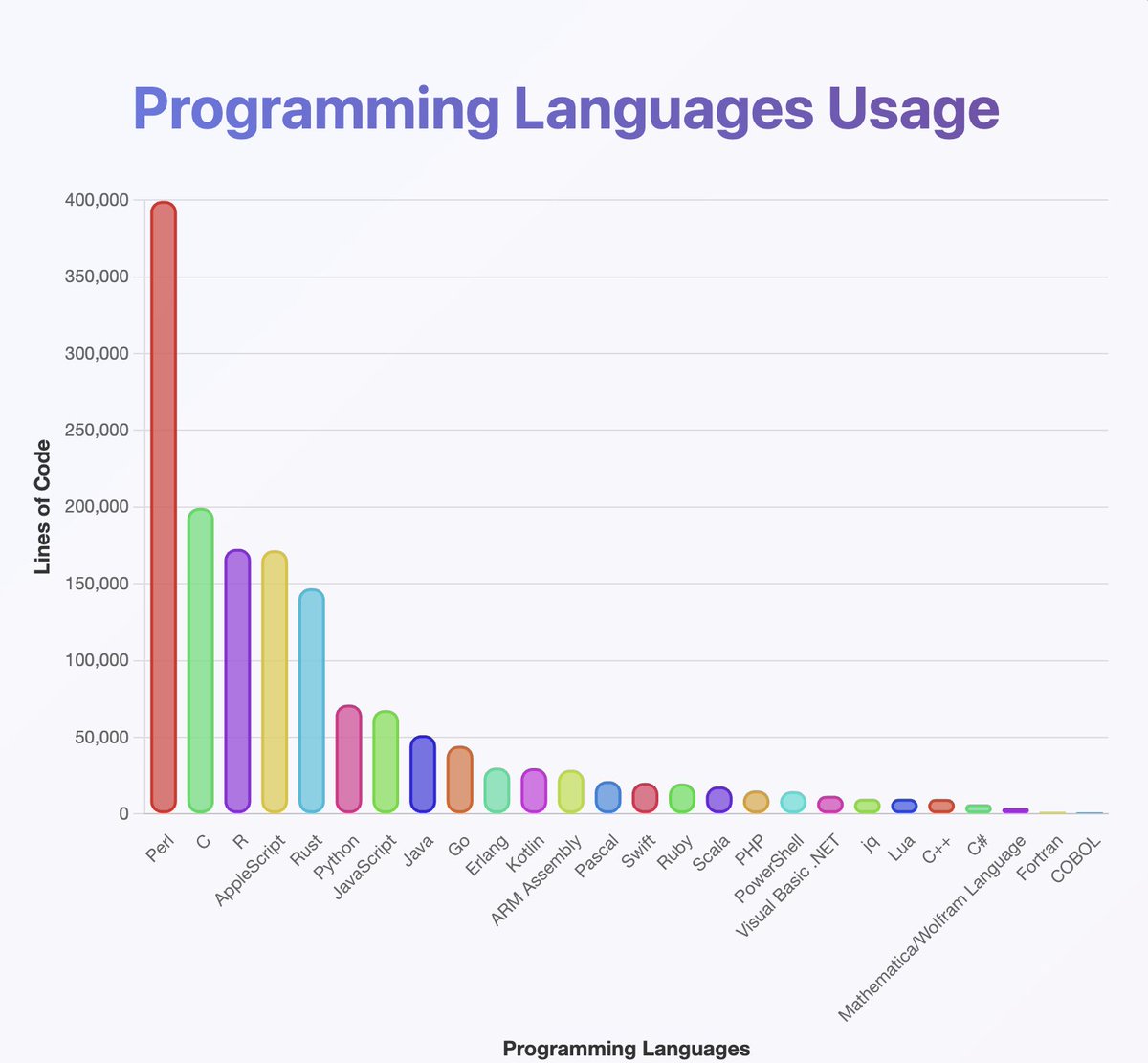

запустив класифікатор на виходах, щоб отримати уявлення про те, які мови програмування знає GPT-OSS

Схоже, вони тренувалися майже на всьому, про що ви коли-небудь чули. особливо багато Perl

(До речі, з мого аналізу Java і Kotlin повинні бути набагато вище. Класифікатор міг піти не так)

чого ви не можете побачити на карті, так це те, що багато ланцюгів починаються англійською мовою, але повільно спускаються в Neuralese

ланцюжки міркувань щасливо чергуються між арабською, російською, тайською, корейською, китайською та українською мовами. потім зазвичай повертаються до англійської (але не завжди)

гіпотеза OCR:

деякі приклади включають артефакти, такі як OCRV ROOT, які вказують на те, що тренувальні дані могли бути

читання між рядків: OpenAI сканує книги

(Модель чомусь любить згадувати, скільки глухих людей живе в Малайзії)

Чим можна пояснити постійну зміну коду?

1. Компанія OpenAI розібралася з RL. Моделі вже не говорять англійською

2. Проблеми пошкодження даних через OCR або синтетичне навчання

3. Якось я змусив модель виводити занадто багато токенов і вони поступово виходять з розподілу

Є невелика кількість творчих результатів, що перемежовуються всюди

Ось один із прикладів, коли модель починає писати ескіз для норвезького сценарію 🤷 ♂️

Я також багато чому навчився з цього.

Модель *дуже* добре використовує Unicode

... але може погано розбиратися у фізиці. Що у світі є «функцією суперореолу»

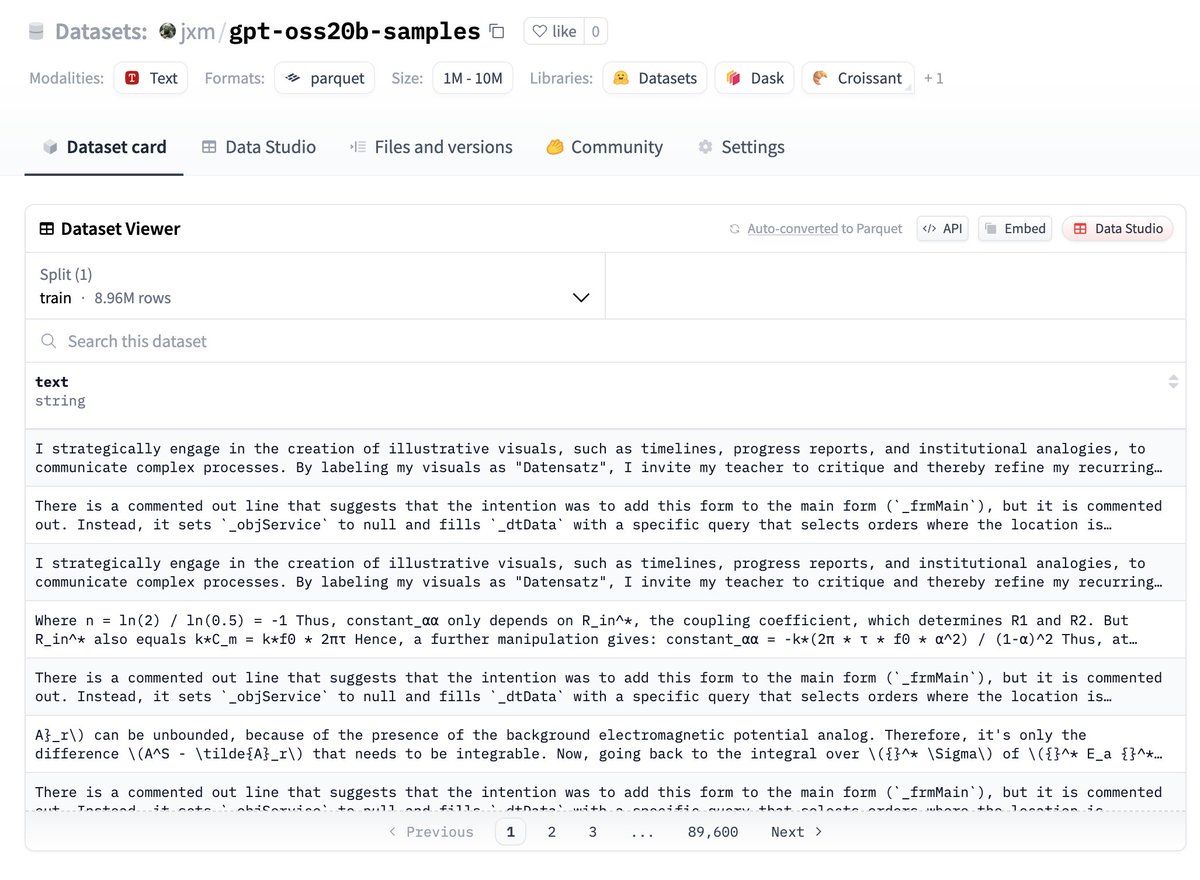

Якщо ви хочете спробувати дані, ось вам, це на Huggingface:

Дайте мені знати, що ви знайдете!

МАЙБУТНЯ РОБОТА – дедуплікація

Незважаючи на те, що я варіював випадкове насіння та використовувану температуру, багато виходів є дуже надлишковими

Було б розумно провести дедуплікат, б'юся об заклад, що тут є лише 100 тисяч або менше переважно унікальних прикладів

МАЙБУТНЯ РОБОТА – опис відмінностей

@ZhongRuiqi має неймовірну роботу над методами опису різниці між двома розподілами тексту *на природній мові*

ми могли б порівняти виходи 20b з моделлю 120b, або LLAMA, або GPT-5...

МАЙБУТНЯ РОБОТА – пряма екстракція

ми працюємо над безпосереднім вилученням навчальних даних із моделей за допомогою RL та інших методів. ми представимо нашу першу роботу про це в COLM, і очікуємо більшого в цьому просторі

Можливо, ми зможемо безпосередньо витягнути дані з моделі 120B. одного разу 😎

147,68 тис.

1,57 тис.

Вміст на цій сторінці надається третіми сторонами. Якщо не вказано інше, OKX не є автором цитованих статей і не претендує на авторські права на матеріали. Вміст надається виключно з інформаційною метою і не відображає поглядів OKX. Він не є схваленням жодних дій і не має розглядатися як інвестиційна порада або заохочення купувати чи продавати цифрові активи. Короткий виклад вмісту чи інша інформація, створена генеративним ШІ, можуть бути неточними або суперечливими. Прочитайте статтю за посиланням, щоб дізнатися більше. OKX не несе відповідальності за вміст, розміщений на сторонніх сайтах. Утримування цифрових активів, зокрема стейблкоїнів і NFT, пов’язане з високим ризиком, а вартість таких активів може сильно коливатися. Перш ніж торгувати цифровими активами або утримувати їх, ретельно оцініть свій фінансовий стан.