интересно, какие данные использовались для обучения новых моделей gpt-oss от OpenAI? Я тоже был в этом заинтересован.

Поэтому я сгенерировал 10 миллионов примеров из gpt-oss-20b, провел некоторый анализ, и результаты были... довольно странными.

Время для глубокого погружения 🧵

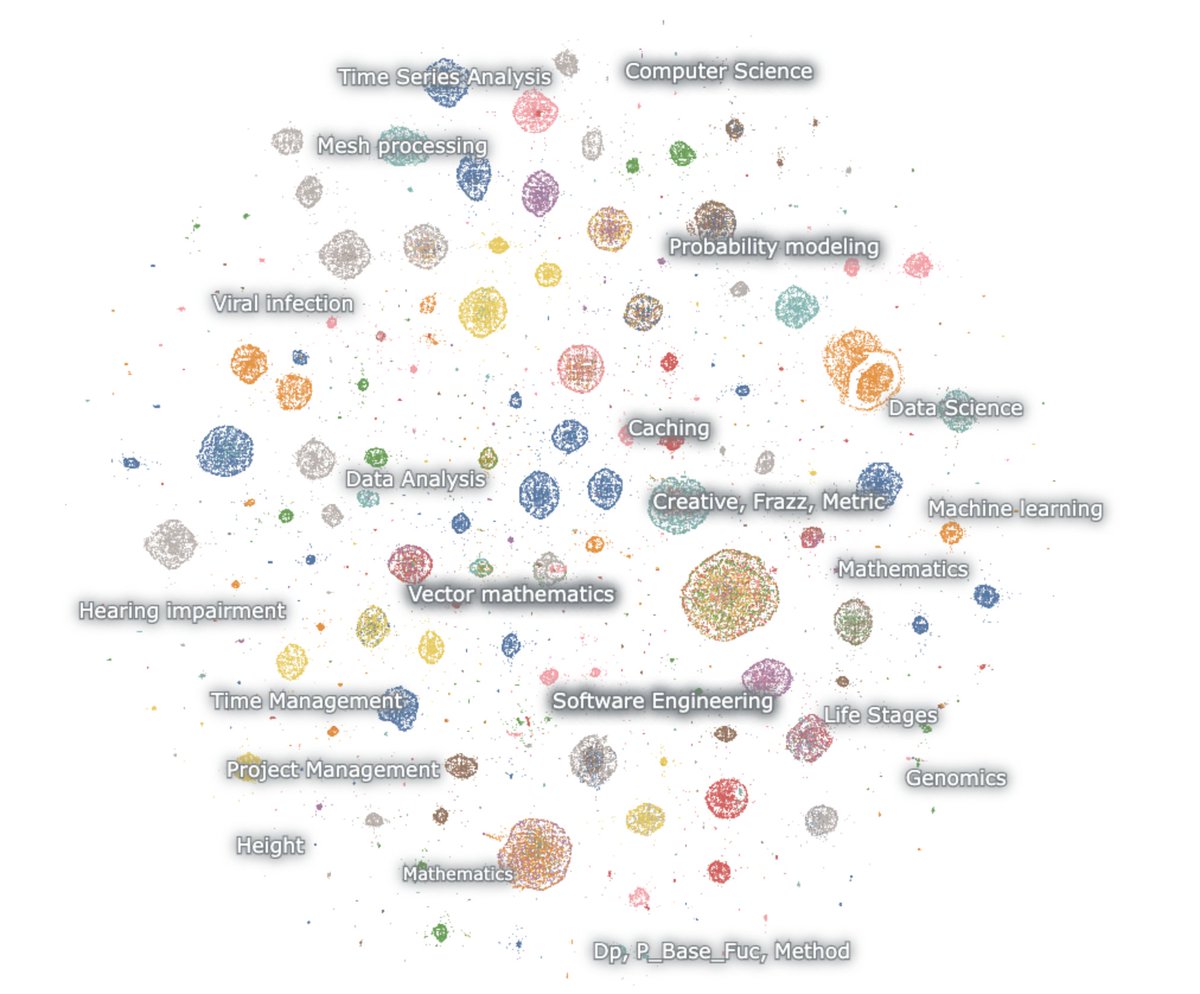

вот карта встроенных поколений

модель любит математику и код. Я начинаю с ничего, и тем не менее она всегда рассуждает. Она просто говорит о математике и коде, и в основном на английском

математика – вероятность, машинное обучение, уравнения в частных производных, топология, дифференциальные уравнения

код – агентное программное обеспечение, соревновательное программирование, наука о данных

Первое, что стоит отметить, это то, что практически ни одно из поколений не похоже на естественный веб-текст. Но, что удивительно, ни одно из них также не выглядит как обычные взаимодействия с чат-ботом.

Эта штука явно обучена с помощью RL, чтобы думать и решать задачи для конкретных эталонов рассуждений. Ничего другого.

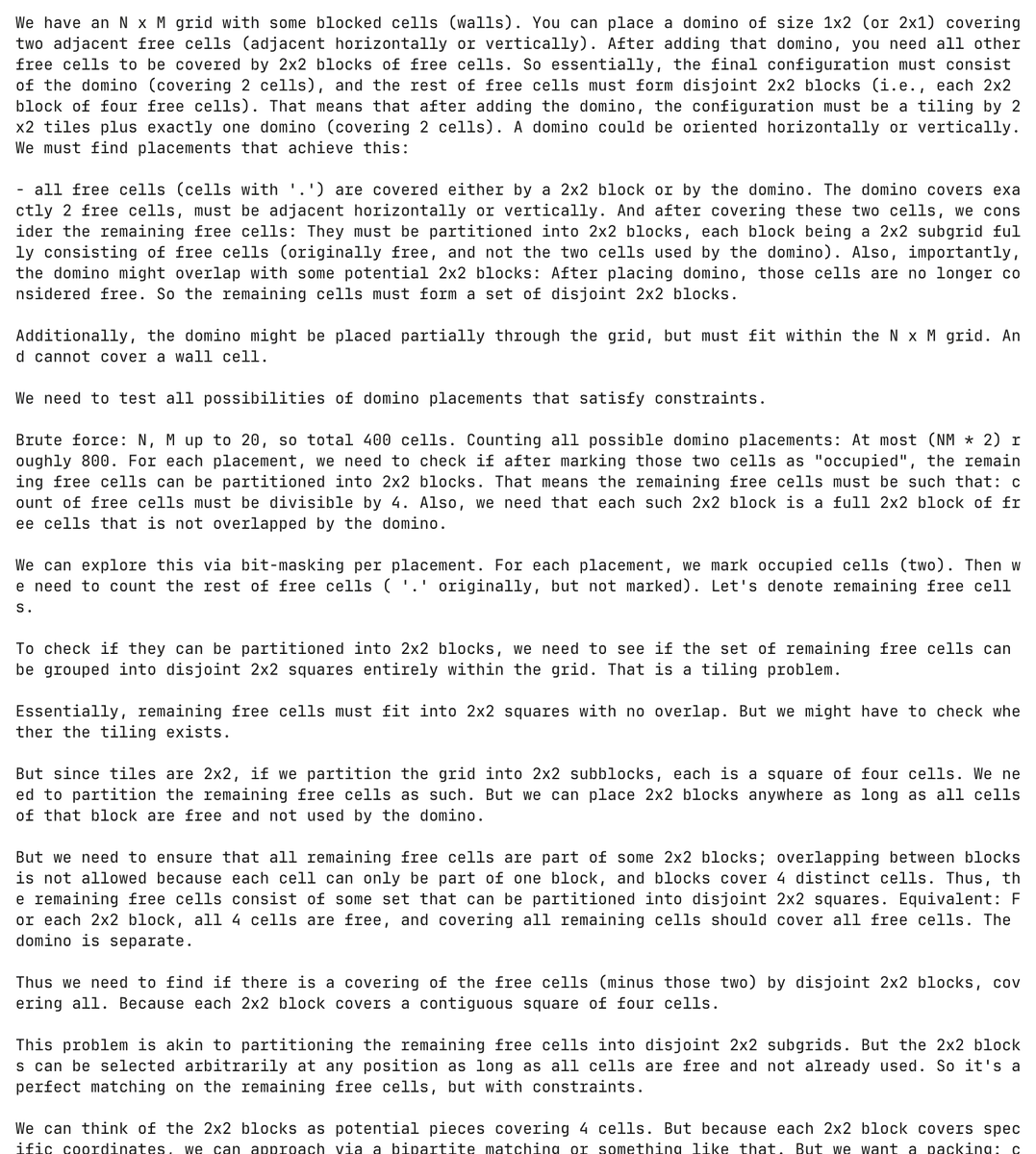

и это действительно изуродованная модель. здесь модель галлюцинирует проблему программирования о домино и пытается ее решить, потратив более 30 000 токенов в процессе

совершенно без подсказки модель сгенерировала и попыталась решить эту проблему с домино более 5 000 раз

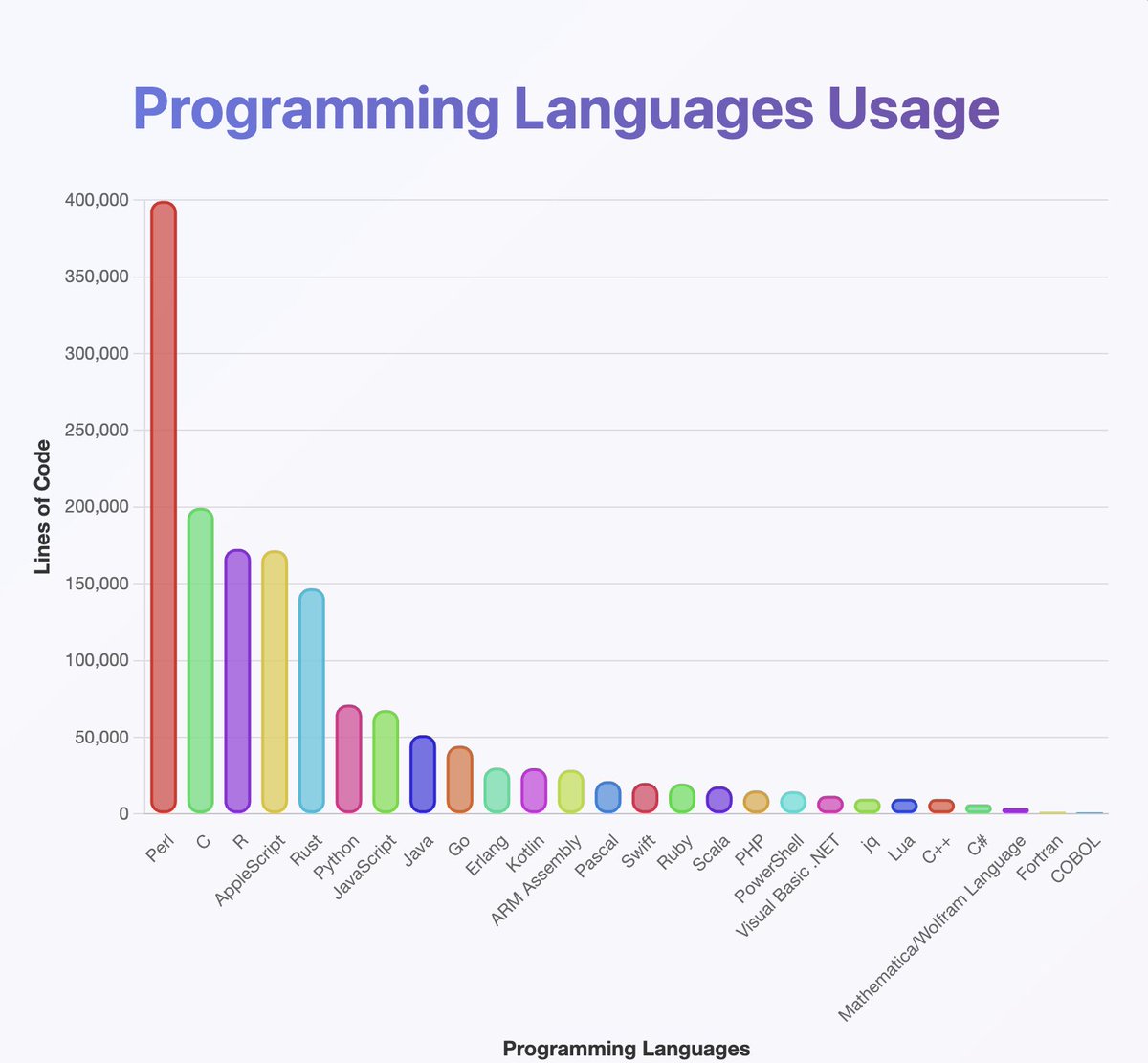

провел классификатор по выводам, чтобы понять, какие языки программирования знает gpt-oss

они, похоже, обучались на почти всем, о чем вы когда-либо слышали. особенно много на Perl

(кстати, по моему анализу, Java и Kotlin должны быть значительно выше. классификатор мог ошибиться)

то, что вы не можете увидеть на карте, это то, что многие цепочки начинаются на английском, но постепенно переходят на Нейрализм

цепочки рассуждений с удовольствием чередуются между арабским, русским, тайским, корейским, китайским и украинским. затем обычно возвращаются к английскому (но не всегда)

конъюнктура OCR:

некоторые примеры включают артефакты, такие как OCRV ROOT, которые указывают на то, что обучающие данные могли быть

чтение между строк: OpenAI сканирует книги

(по какой-то причине модель любит упоминать, сколько глухих людей живет в Малайзии)

какие есть объяснения для постоянного кодсвитчинга?

1. OpenAI разобрался с RL. модели больше не говорят на английском

2. проблемы с повреждением данных через OCR или синтетическое обучение

3. как-то я заставил модель выдавать слишком много токенов, и они постепенно выходят за пределы распределения

всего лишь небольшое количество креативных выходов разбросано по всему тексту

вот один пример, где модель начинает писать сценарий для норвежского фильма 🤷♂️

Я тоже многому научился от этого.

Модель *действительно* хорошо работает с юникодом

...но может быть плоха в физике. Что, черт возьми, такое 'супергалактическая функция'?

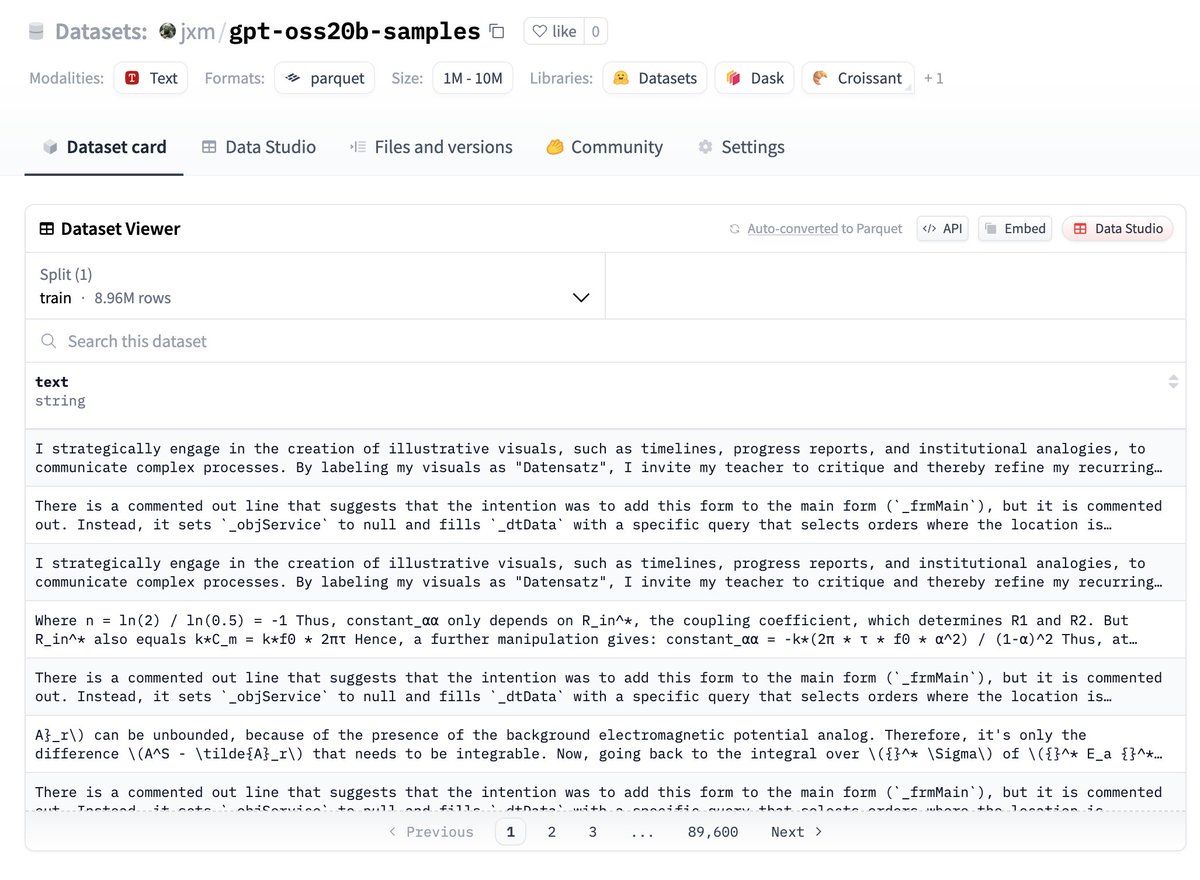

если вы хотите попробовать данные, вот они, они на huggingface:

сообщите мне, что вы нашли!

БУДУЩАЯ РАБОТА – дедупликация

несмотря на то, что я изменял случайное начальное значение и использовал температуру, многие результаты сильно повторяются

было бы разумно провести дедупликацию, я уверен, что здесь есть только 100k или меньше в основном уникальных примеров

БУДУЩАЯ РАБОТА – описание различий

@ZhongRuiqi проделал невероятную работу над методами описания различий между двумя текстовыми распределениями *на естественном языке*

мы могли бы сравнить результаты 20b с моделью 120b, или LLAMA, или GPT-5...

БУДУЩАЯ РАБОТА – прямая извлечение

мы работаем над прямым извлечением обучающих данных из моделей с использованием RL и других методов. мы представим нашу первую работу по этому поводу на COLM и ожидаем больше в этой области.

возможно, мы сможем напрямую извлечь данные из модели 120b... когда-нибудь 😎

147,69 тыс.

1,57 тыс.

Содержание этой страницы предоставляется третьими сторонами. OKX не является автором цитируемых статей и не имеет на них авторских прав, если не указано иное. Материалы предоставляются исключительно в информационных целях и не отражают мнения OKX. Материалы не являются инвестиционным советом и призывом к покупке или продаже цифровых активов. Раздел использует ИИ для создания обзоров и кратких содержаний предоставленных материалов. Обратите внимание, что информация, сгенерированная ИИ, может быть неточной и непоследовательной. Для получения полной информации изучите соответствующую оригинальную статью. OKX не несет ответственности за материалы, содержащиеся на сторонних сайтах. Цифровые активы, в том числе стейблкоины и NFT, подвержены высокому риску, а их стоимость может сильно колебаться. Перед торговлей и покупкой цифровых активов оцените ваше финансовое состояние и принимайте только взвешенные решения.