对OpenAI的新gpt-oss模型的训练数据感到好奇吗?我也是。

所以我从gpt-oss-20b生成了1000万个示例,进行了分析,结果是……相当离奇。

是时候深入探讨了 🧵

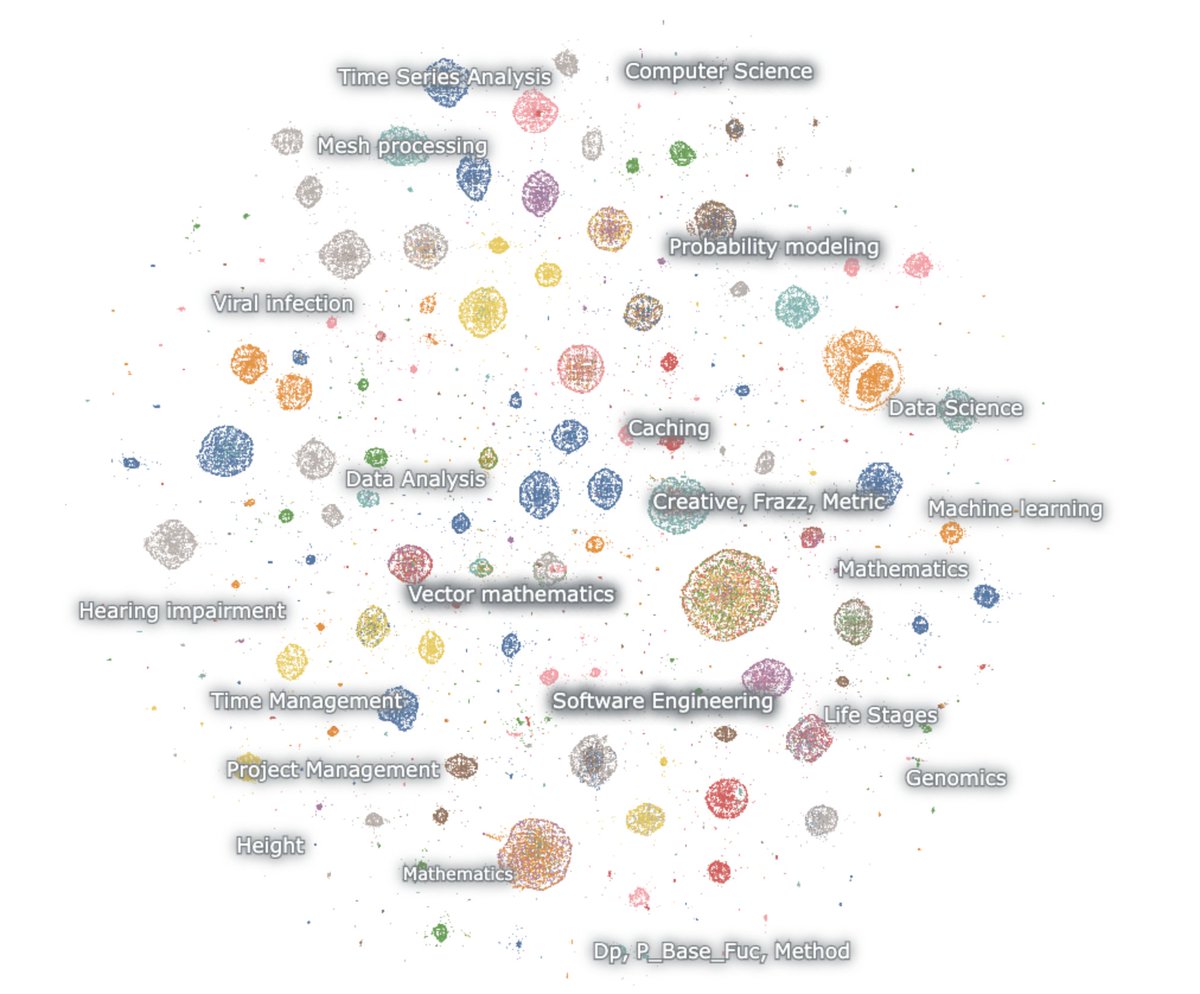

这是嵌入式生成的地图

这个模型热爱数学和代码。我什么都不提示,它却总是能推理。它只谈论数学和代码,主要是用英语

数学 – 概率,机器学习,偏微分方程,拓扑学,微分方程

代码 – 代理软件,竞争编程,数据科学

首先要注意的是,几乎没有一代人看起来像自然的网络文本。但令人惊讶的是,它们也没有看起来像正常的聊天机器人互动。

这个东西显然是通过强化学习训练的,旨在思考和解决特定推理基准的任务。没有其他的。

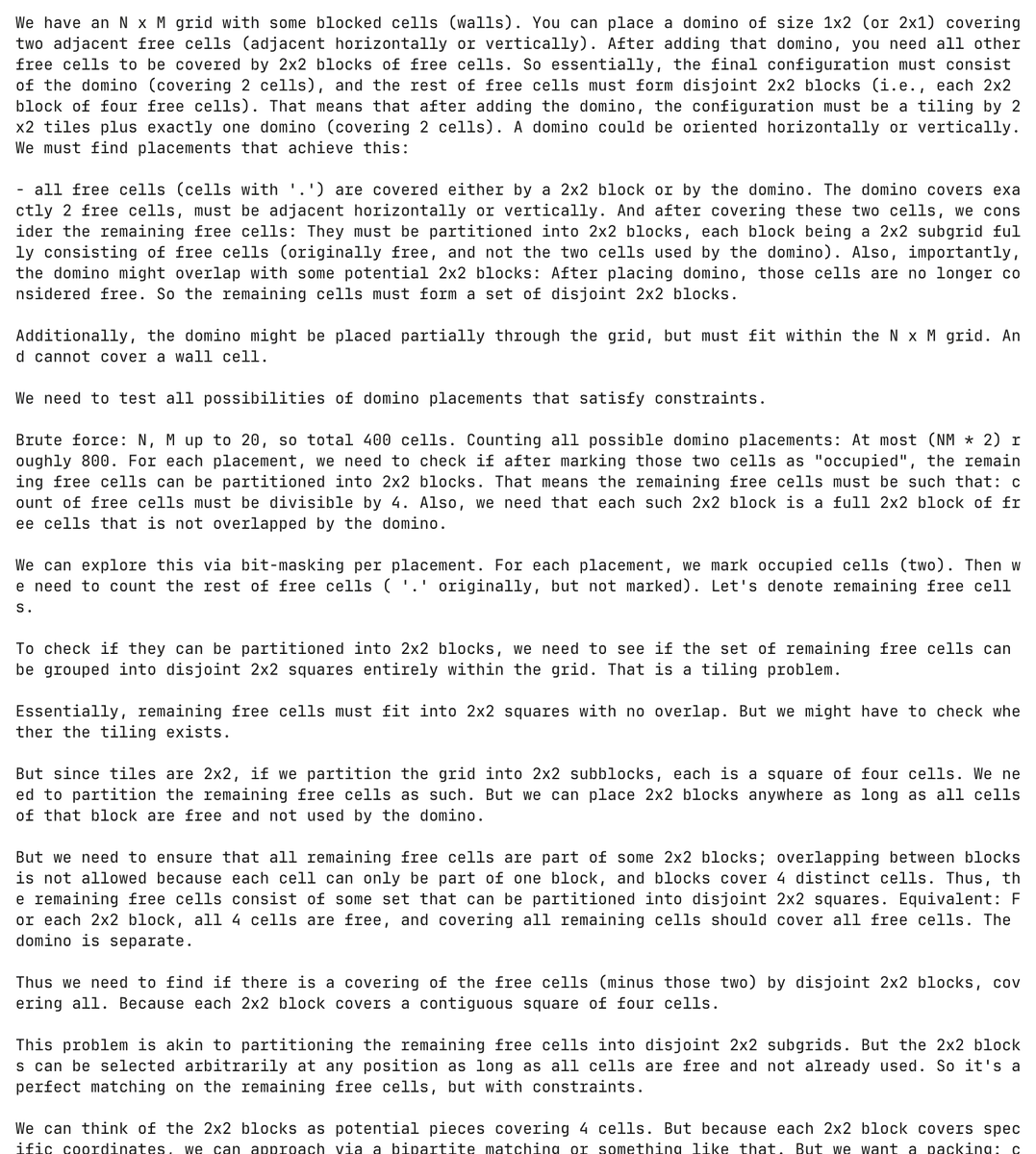

这确实是一个痛苦的模型。在这里,模型幻想出一个关于多米诺骨牌的编程问题,并试图解决它,过程中花费了超过30,000个token。

完全没有提示,模型生成并尝试解决这个多米诺问题超过5,000次。

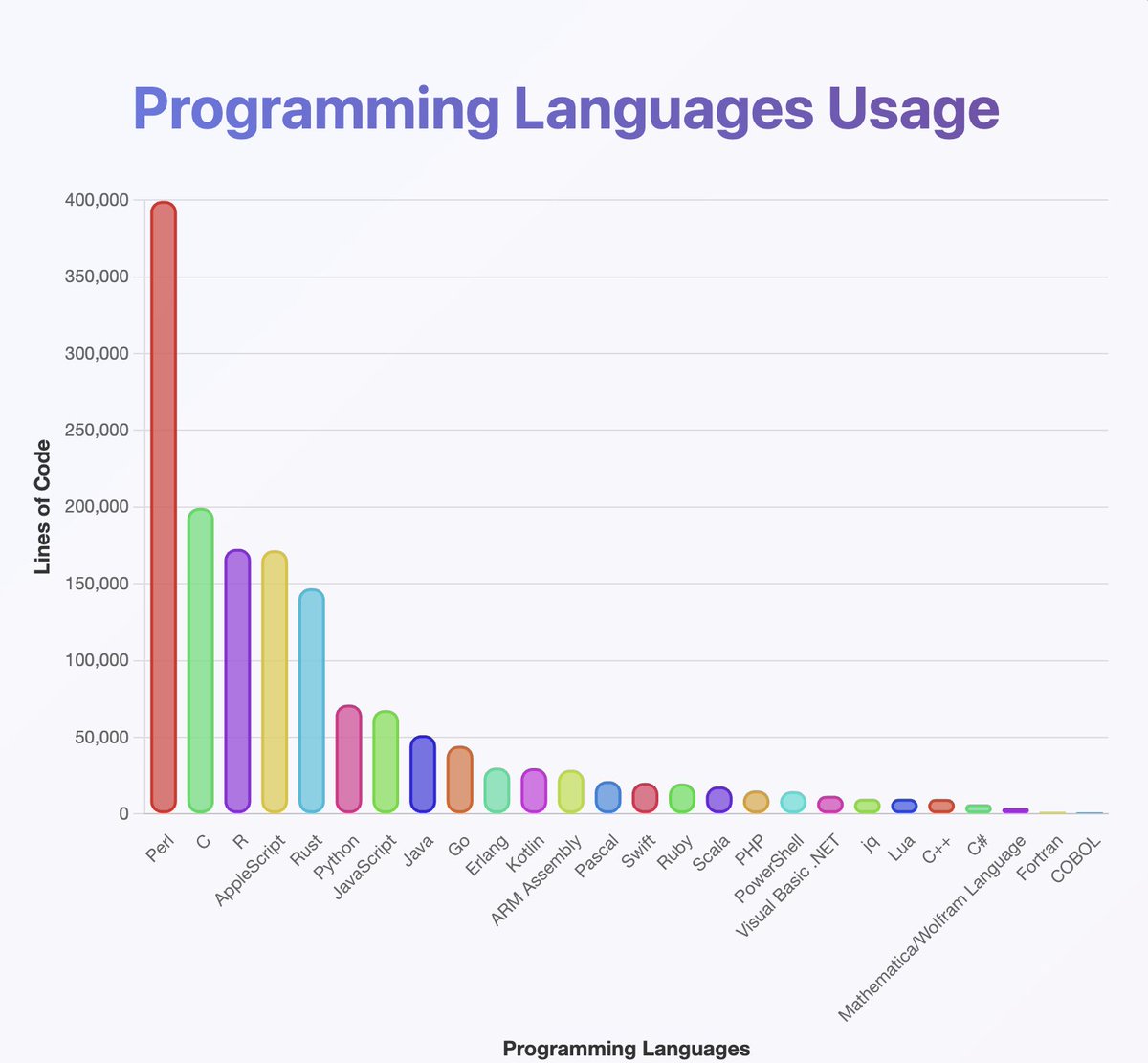

对输出结果进行了分类,以了解gpt-oss知道哪些编程语言

他们似乎几乎训练了你听说过的所有语言,尤其是很多Perl

(顺便说一下,根据我的分析,Java和Kotlin的排名应该更高。分类器可能出错了)

从地图上看不到的是,许多链条开始于英语,但逐渐转变为神经语言。

推理链条愉快地在阿拉伯语、俄语、泰语、韩语、中文和乌克兰语之间交替。然后通常会回到英语(但并不总是如此)。

OCR猜想:

一些例子包括像OCRV ROOT这样的文物,这表明训练数据可能已经被

字里行间:OpenAI正在扫描书籍

(出于某种原因,该模型喜欢提到马来西亚有多少聋人)

常见的代码切换解释有哪些?

1. OpenAI 已经搞定了强化学习,模型不再说英语

2. 通过光学字符识别或合成训练导致的数据损坏问题

3. 不知怎么的,我强迫模型输出了太多的标记,它们逐渐偏离了分布

在这里有少量创意输出穿插其中

这是一个例子,模型开始为挪威剧本写草稿 🤷♂️

我也从这个中学到了很多。

这个模型在使用unicode方面*真的*很好。

……但在物理学方面可能不太好。‘超光环函数’到底是什么?

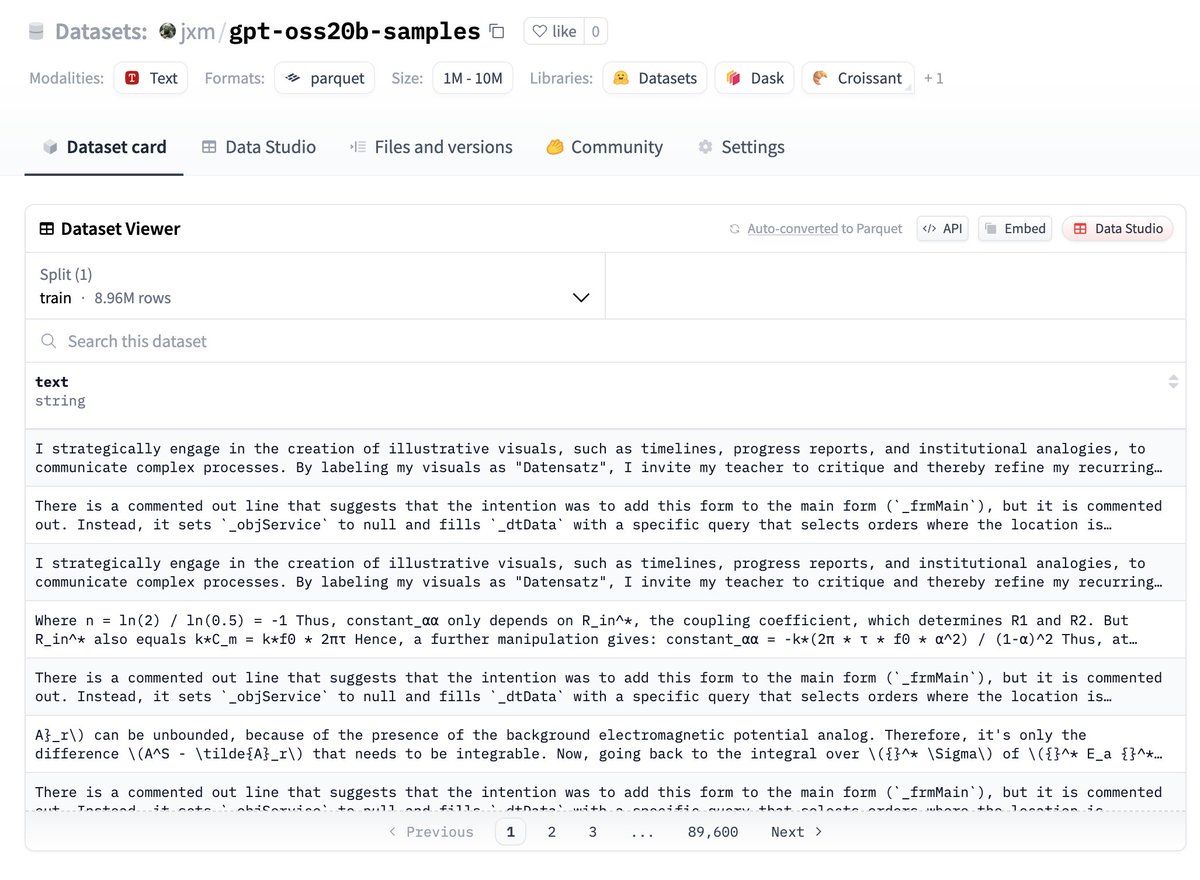

如果你想尝试这些数据,这里给你,放在 huggingface 上:

告诉我你发现了什么!

未来工作 - 去重

尽管我改变了随机种子并使用了温度,但很多输出高度重复

进行去重是明智的,我敢打赌这里只有10万或更少的主要独特示例

未来工作 - 描述差异

@ZhongRuiqi 在描述两个文本分布之间的差异方面有一些令人难以置信的工作 *用自然语言*

我们可以比较 20b 模型与 120b 模型,或者 LLAMA,或者 GPT-5 的输出...

未来工作 – 直接提取

我们正在研究使用强化学习和其他方法直接从模型中提取训练数据。我们将在COLM上展示我们的第一项工作,并期待在这个领域有更多进展。

我们可能能够直接从120b模型中提取数据……有一天 😎

14.77万

1,573

本页面内容由第三方提供。除非另有说明,欧易不是所引用文章的作者,也不对此类材料主张任何版权。该内容仅供参考,并不代表欧易观点,不作为任何形式的认可,也不应被视为投资建议或购买或出售数字资产的招揽。在使用生成式人工智能提供摘要或其他信息的情况下,此类人工智能生成的内容可能不准确或不一致。请阅读链接文章,了解更多详情和信息。欧易不对第三方网站上的内容负责。包含稳定币、NFTs 等在内的数字资产涉及较高程度的风险,其价值可能会产生较大波动。请根据自身财务状况,仔细考虑交易或持有数字资产是否适合您。