penasaran dengan data pelatihan model gpt-oss baru OpenAI? Saya juga.

Jadi saya menghasilkan 10 juta contoh dari gpt-oss-20b, menjalankan beberapa analisis, dan hasilnya adalah... cukup aneh

Saatnya menyelam 🧵 lebih dalam

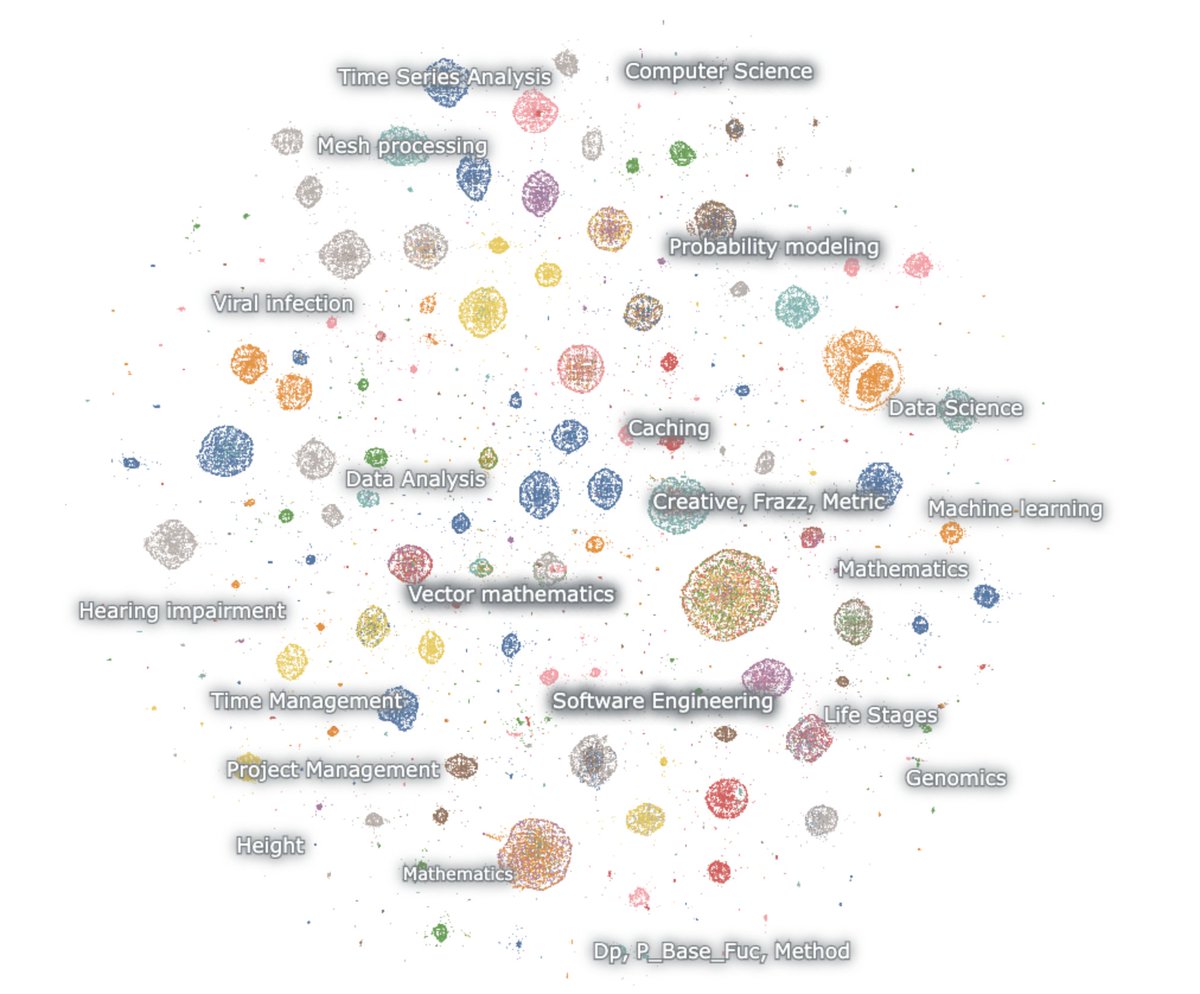

Berikut adalah peta generasi yang disematkan

Model ini menyukai matematika dan kode. Saya meminta tanpa apa-apa namun itu selalu beralasan. itu hanya berbicara tentang matematika dan kode, dan sebagian besar dalam bahasa Inggris

matematika – probabilitas, ML, PDE, topologi, diffeq

Kode – Perangkat lunak agen, pemrograman kompetitif, ilmu data

Hal pertama yang perlu diperhatikan adalah bahwa praktis tidak ada generasi yang menyerupai teks web alami. Tapi yang mengejutkan tidak ada yang terlihat seperti interaksi chatbot normal juga

hal ini dilatih dengan jelas melalui RL untuk berpikir dan menyelesaikan tugas untuk tolok ukur penalaran tertentu. tidak ada yang lain.

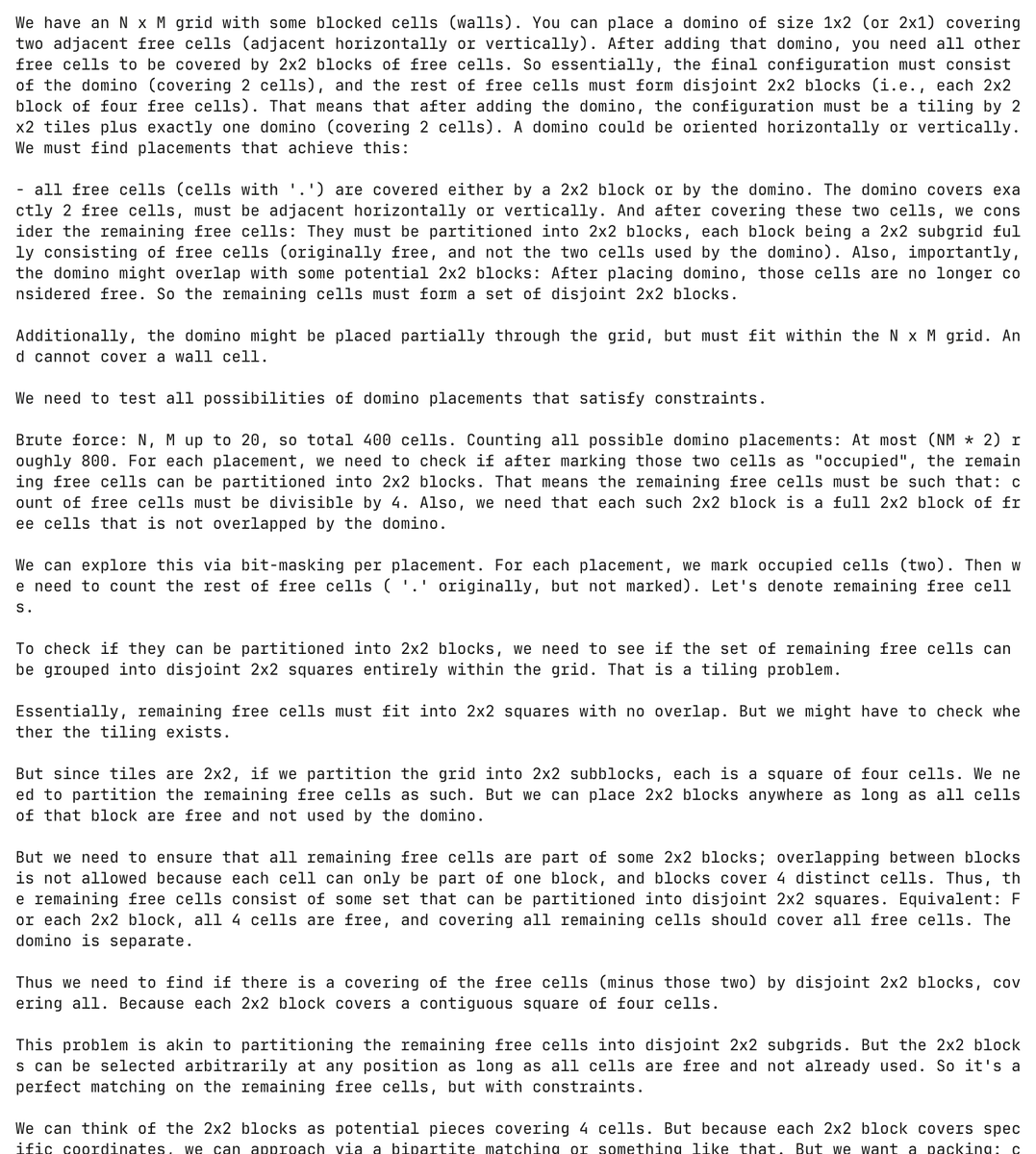

dan itu benar-benar model yang tersiksa. Di sini model berhalusinasi masalah pemrograman tentang domino dan mencoba menyelesaikannya, menghabiskan lebih dari 30.000 token dalam prosesnya

Benar-benar tanpa diminta, model menghasilkan dan mencoba memecahkan masalah domino ini lebih dari 5.000 kali terpisah

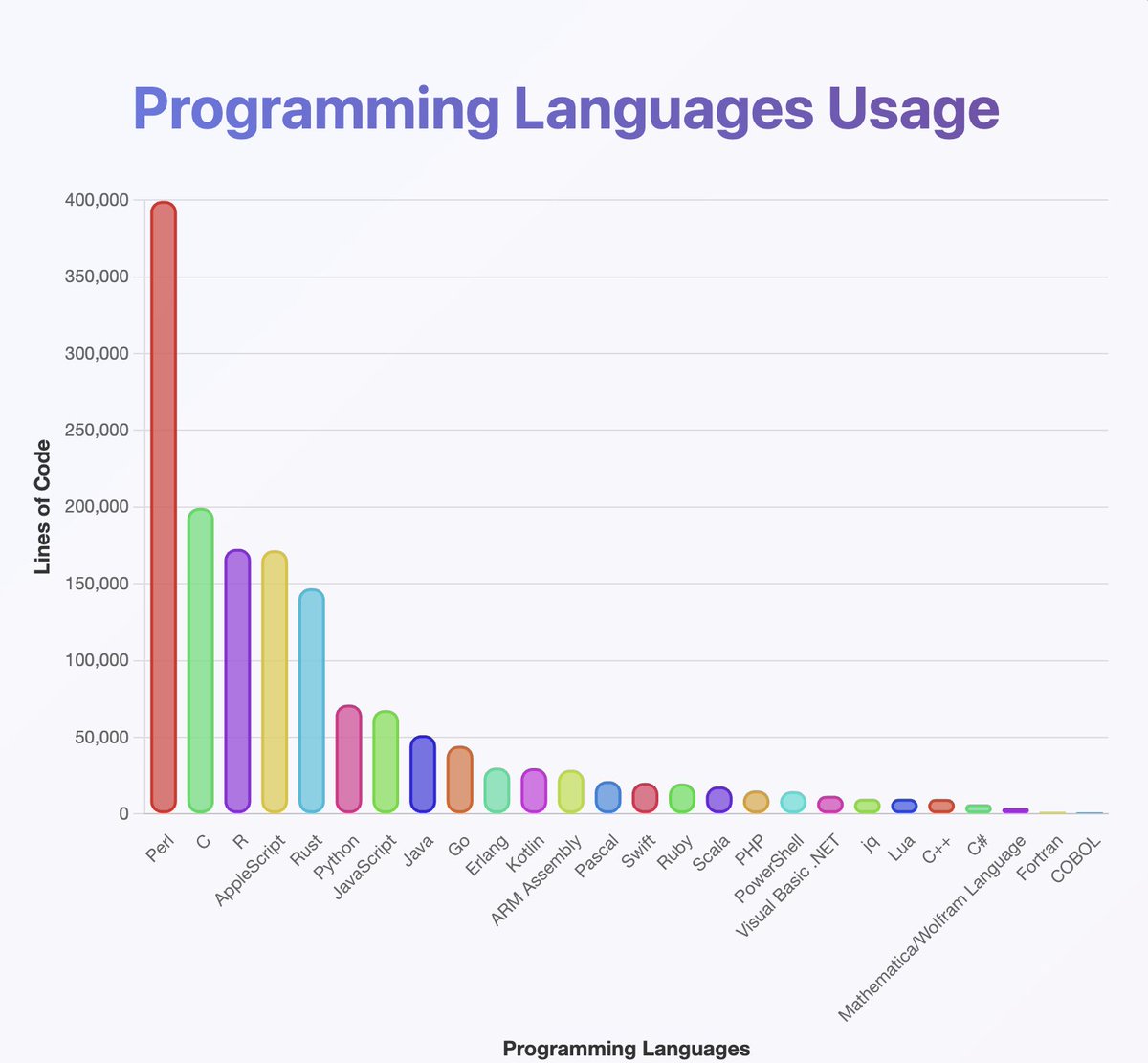

menjalankan pengklasifikasi di atas output untuk mendapatkan gambaran bahasa pemrograman mana yang diketahui gpt-oss

mereka tampaknya telah berlatih pada hampir semua yang pernah Anda dengar. terutama banyak Perl

(btw, dari analisis saya Java dan Kotlin seharusnya jauh lebih tinggi. pengklasifikasi mungkin salah)

apa yang tidak dapat Anda lihat dari peta adalah banyak rantai dimulai dalam bahasa Inggris tetapi perlahan-lahan turun ke Neuralese

rantai penalaran dengan senang hati bergantian antara bahasa Arab, Rusia, Thailand, Korea, Cina, dan Ukraina. kemudian biasanya kembali ke bahasa Inggris (tetapi tidak selalu)

dugaan OCR:

beberapa contoh termasuk artefak seperti OCRV ROOT, yang menunjukkan data pelatihan mungkin telah

membaca di antara garis: OpenAI sedang memindai buku

(untuk beberapa alasan model suka menyebutkan berapa banyak orang tuli yang tinggal di Malaysia)

Apa saja penjelasan untuk peralihan kode konstan?

1. OpenAI telah menemukan RL. Para model tidak lagi berbicara bahasa Inggris

2. Masalah Kerusakan Data melalui OCR atau pelatihan sintetis

3. Entah bagaimana saya memaksa model untuk mengeluarkan terlalu banyak token dan mereka secara bertahap bergeser keluar dari distribusi

Ada sejumlah kecil output kreatif yang diselingi di seluruh

Berikut adalah salah satu contoh di mana model mulai menulis sketsa untuk skenario 🤷 ♂️ Norwegia

Saya juga belajar banyak dari yang satu ini.

Modelnya *sangat* bagus dalam menggunakan Unicode

... Tapi mungkin buruk dalam fisika. Apa di dunia itu 'fungsi superhalo'

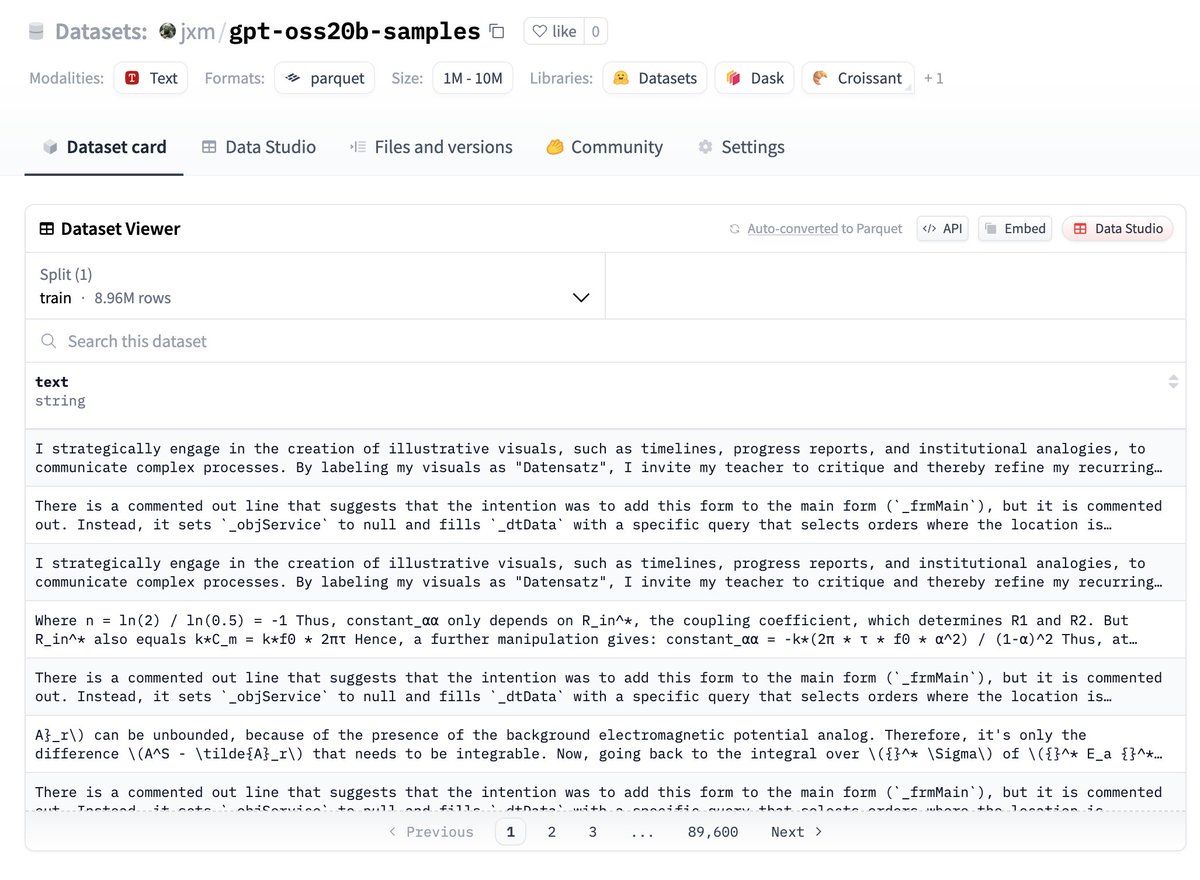

Jika Anda ingin mencoba datanya, ini dia, itu di Huggingface:

Beri tahu saya apa yang Anda temukan!

PEKERJAAN MASA DEPAN – DEDUPLIKASI

Meskipun saya memvariasikan benih acak dan suhu yang digunakan, banyak output yang sangat berlebihan

Akan bijaksana untuk mendeduplikasi, saya yakin hanya ada 100 ribu atau kurang contoh yang sebagian besar unik di sini

PEKERJAAN MASA DEPAN – menggambarkan perbedaan

@ZhongRuiqi memiliki beberapa pekerjaan luar biasa tentang metode untuk menggambarkan perbedaan antara dua distribusi teks *dalam bahasa alami*

kita dapat membandingkan output 20b dengan model 120b, atau LLAMA, atau GPT-5...

PEKERJAAN MASA DEPAN – EKSTRAKSI LANGSUNG

kami sedang berupaya mengekstrak data pelatihan secara langsung dari model menggunakan RL dan metode lainnya. kami akan mempresentasikan karya pertama kami tentang ini di COLM, dan mengharapkan lebih banyak lagi di ruang ini

Kita mungkin dapat langsung mengekstrak data dari model 120b. suatu hari 😎

147,71 rb

1,57 rb

Konten pada halaman ini disediakan oleh pihak ketiga. Kecuali dinyatakan lain, OKX bukanlah penulis artikel yang dikutip dan tidak mengklaim hak cipta atas materi tersebut. Konten ini disediakan hanya untuk tujuan informasi dan tidak mewakili pandangan OKX. Konten ini tidak dimaksudkan sebagai dukungan dalam bentuk apa pun dan tidak dapat dianggap sebagai nasihat investasi atau ajakan untuk membeli atau menjual aset digital. Sejauh AI generatif digunakan untuk menyediakan ringkasan atau informasi lainnya, konten yang dihasilkan AI mungkin tidak akurat atau tidak konsisten. Silakan baca artikel yang terkait untuk informasi lebih lanjut. OKX tidak bertanggung jawab atas konten yang dihosting di situs pihak ketiga. Kepemilikan aset digital, termasuk stablecoin dan NFT, melibatkan risiko tinggi dan dapat berfluktuasi secara signifikan. Anda perlu mempertimbangkan dengan hati-hati apakah trading atau menyimpan aset digital sesuai untuk Anda dengan mempertimbangkan kondisi keuangan Anda.