𝐃𝐞𝐜𝐞𝐧𝐭𝐫𝐚𝐥𝐢𝐳𝐞𝐝 𝐀𝐈 : 𝐒𝐢𝐱 𝐔𝐧𝐝𝐞𝐫 𝐓𝐡𝐞 𝐑𝐚𝐝𝐚𝐫 𝐎𝐩𝐞𝐫𝐚𝐭𝐨𝐫𝐬 𝐑𝐞𝐰𝐢𝐫𝐢𝐧𝐠 𝐂𝐨𝐦𝐩𝐮𝐭𝐞, 𝐏𝐫𝐢𝐯𝐚𝐜𝐲, 𝐀𝐧𝐝 𝐎𝐰𝐧𝐞𝐫𝐬𝐡𝐢𝐩

Web3 ne manque pas de bruit, mais le travail qui compte se fait là où les équipes comblent des lacunes d'infrastructure tenaces :

• Calcul vérifiable,

• Souveraineté des données, et

• Incitations alignées.

Voici un guide de terrain pour six de ces bâtisseurs dont l'adhésion laisse déjà présager le prochain changement de paradigme pour l'IA.👇

---

Numerai (@numerai) : Intelligence collective, collatéralisée

Numerai de San Francisco transforme un tournoi mondial de science des données en un fonds de couverture en direct. Les contributeurs soumettent des prédictions cryptées et misent des $NMR. Le protocole les agrège en un seul méta-modèle et dimensionne automatiquement les positions dans les actions américaines. Les paiements suivent le PnL réel, tandis que les mauvais modèles perdent leur mise, créant ce que le fondateur @richardcraib appelle "skin-in-the-math". Numerai a maintenant levé environ 32,8 millions de dollars, avec plus de 150 millions de dollars en NMR misés, et distribue des sommes à six chiffres en récompenses hebdomadaires à des milliers de quants pseudonymes.

---

Gensyn (@gensynai) : Preuve d'apprentissage à l'échelle du cloud

Les marchés de GPU sont déformés, mais Gensyn contourne les obstacles en recrutant tout matériel inactif et en vérifiant le travail avec des vérifications optimistes et une "preuve d'apprentissage" à connaissance nulle. Les développeurs soumettent un travail d'entraînement, les pairs font le gros du travail, et la correction est réglée sur la chaîne avant que le paiement ne soit effectué. L'équipe londonienne a levé environ 43 millions de dollars auprès de a16z crypto et d'autres et vise le fine-tuning des LLM, où le calcul est à la fois rare et coûteux.

---

MyShell (@myshell_ai) : Agents détenus par les utilisateurs en tant que biens numériques

MyShell offre aux créateurs un studio sans code pour construire des assistants vocaux, des NPC de jeux ou des bots de productivité, puis les conditionne en tant que NFTs et gagne des redevances en tokens $SHELL lorsque d'autres les déploient ou les remixent. Le projet a attiré plus de 1 million d'utilisateurs et 16,6 millions de dollars de financement, en tant que couche orientée consommateur pour une IA personnalisée qui est portable à travers les applications. Pas de clé API, pas de gardien.

---

(@flock_io) : Apprentissage fédéré pour des modèles préservant la vie privée

Dans des secteurs où les données ne peuvent jamais quitter l'appareil, comme les hôpitaux ou les capteurs de smart factory, FLock orchestre l'entraînement de petits modèles de langage à travers des milliers de nœuds. Chaque mise à jour est vérifiée avec des preuves ZK avant d'être intégrée dans le modèle global, et les contributeurs gagnent des tokens $FLO en proportion de l'utilité prouvée. Un nouveau tour de financement de 3 millions de dollars dirigé par DCG porte le financement total à 11 millions de dollars et soutient des pilotes dans l'imagerie médicale et l'IoT industriel.

---

Ritual (@ritualnet) : Un L1 souverain pour les charges de travail IA

Ritual construit une couche 1 où les modèles vivent en tant que contrats intelligents, versionnés, gouvernables et évolutifs par vote de token. Les exécuteurs hors chaîne gèrent les calculs lourds, renvoient les résultats sur la chaîne et collectent des frais. La conception promet une isolation des fautes si un modèle tombe en panne afin que la gouvernance puisse le restaurer sans arrêter le réseau. Les investisseurs ont soutenu la thèse avec une série A de 25 millions de dollars.

---

Sahara AI (@SaharaLabsAI) : Agents avec mémoire partagée

Sahara déploie des agents autonomes sur un substrat pair-à-pair et stocke leurs graphes de connaissances évolutifs sur la chaîne, de sorte que chaque étape de raisonnement soit vérifiable. Les contributeurs qui téléchargent des faits de haute qualité gagnent des récompenses en tokens, améliorant le graphe et les agents qui en dépendent. L'entreprise a sécurisé environ 49 millions de dollars, y compris une série A dirigée par Pantera, et réalise des pilotes d'analytique de chaîne d'approvisionnement où des données de fournisseurs opaques avaient précédemment freiné l'adoption de l'IA.

---

Signaux stratégiques

• Pression sur les coûts par rapport à l'engouement : Chaque projet plie l'économie unitaire en sa faveur. @numerai en externalisant la R&D, @gensynai en arbitrant le silicium inutilisé, @flock_io en éliminant les coûts de migration des données.

• Vérifiabilité comme rempart : L'attestation à connaissance nulle, le staking ou les journaux d'audit sur la chaîne convertissent la confiance en mathématiques, décourageant les imitateurs sans profondeur de recherche similaire.

• Bords composables : Les NFTs d'agents de @myshell_ai peuvent se brancher directement dans la couche d'exécution de Ritual ou consommer des données des graphes de Sahara, à une pile où la provenance voyage avec le modèle.

---

Journal des risques

Les normes d'incitation des tokens, les limites de débit pour les preuves et un cloud incumbent prêt à égaler les prix pèsent lourd.

Le hedge : Soutenir des équipes dont les feuilles de route migrent progressivement des primitives hors chaîne vers des primitives sur chaîne et qui mesurent le succès en fonction des problèmes commerciaux résolus, et non des graphiques de tokens.

---

Conclusion

L'IA décentralisée n'arrivera pas avec une chaîne phare. Elle s'infiltrera à travers des victoires pratiques comme des cycles d'entraînement moins chers, des signaux alpha crowdsourcés et des déploiements préservant la vie privée. Les bâtisseurs ci-dessus vendent déjà ces victoires. Suivez leurs métriques, pas leurs mèmes, et vous verrez la courbe avant qu'elle ne devienne un consensus.

Merci de votre lecture !

Centralisation vs Décentralisation de l'IA : Qu'est-ce qui vaut la peine d'être joué ?

Imaginez deux arènes : l'une est dominée par des géants de la technologie qui gèrent d'énormes centres de données, entraînent des modèles de pointe et établissent les règles. L'autre distribue le calcul, les données et la prise de décision à travers des millions de mineurs, d'appareils en périphérie et de communautés ouvertes. L'endroit où vous choisissez de construire ou d'investir dépend de l'arène que vous croyez capturer la prochaine vague de valeur, ou si la véritable opportunité réside dans le pont entre les deux.

---

Ce que signifie la centralisation et la décentralisation dans l'IA

L'IA centralisée se trouve principalement dans des plateformes cloud hyperscale comme AWS, Azure et Google Cloud, qui contrôlent la majorité des clusters GPU et détiennent 68 % de part de marché mondial du cloud. Ces fournisseurs entraînent de grands modèles, gardent les poids fermés ou sous des licences restrictives (comme on le voit avec OpenAI et Anthropic), et utilisent des ensembles de données propriétaires et des partenariats de données exclusifs. La gouvernance est généralement corporative, dirigée par des conseils d'administration, des actionnaires et des régulateurs nationaux.

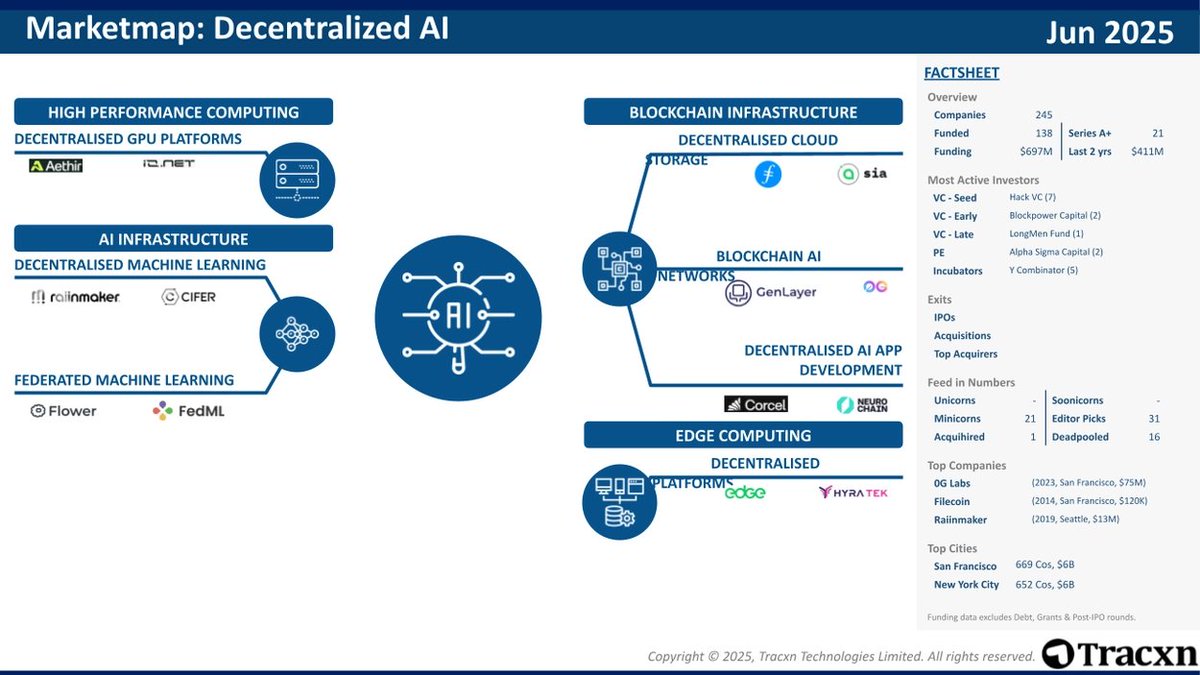

D'autre part, l'IA décentralisée distribue le calcul à travers des marchés GPU peer-to-peer, tels que @akashnet_ et @rendernetwork, ainsi que sur des réseaux d'inférence en chaîne comme @bittensor_. Ces réseaux visent à décentraliser à la fois l'entraînement et l'inférence.

---

Pourquoi la centralisation domine encore

Il existe des raisons structurelles pour lesquelles l'IA centralisée continue de mener.

Entraîner un modèle de pointe, disons, un modèle multilingue de 2 trillions de paramètres, nécessite plus de 500 millions de dollars en matériel, électricité et capital humain. Très peu d'entités peuvent financer et exécuter de telles entreprises. De plus, les obligations réglementaires telles que l'Ordre Exécutif américain sur l'IA et la Loi sur l'IA de l'UE imposent des exigences strictes concernant les tests de sécurité, les rapports de sécurité et la transparence. Répondre à ces exigences crée un fossé de conformité qui favorise les acteurs bien dotés en ressources. La centralisation permet également un suivi de sécurité plus strict et une gestion du cycle de vie à travers les phases d'entraînement et de déploiement.

---

Les fissures du modèle centralisé

Pourtant, cette domination a des vulnérabilités.

Il y a une préoccupation croissante concernant le risque de concentration. En Europe, des dirigeants de 44 grandes entreprises ont averti les régulateurs que la Loi sur l'IA de l'UE pourrait renforcer involontairement les monopoles cloud américains et contraindre le développement régional de l'IA. Les contrôles à l'exportation, en particulier les restrictions GPU dirigées par les États-Unis, limitent qui peut accéder à des calculs haut de gamme, encourageant les pays et les développeurs à se tourner vers des alternatives décentralisées ou ouvertes.

De plus, les prix des API pour les modèles propriétaires ont connu plusieurs augmentations depuis 2024. Ces rentes de monopole motivent les développeurs à envisager des solutions à coût réduit, à poids ouvert ou décentralisées.

---

IA décentralisée

Nous avons des marchés de calcul en chaîne tels qu'Akash, Render et @ionet qui permettent aux propriétaires de GPU de louer leur capacité inutilisée à des charges de travail d'IA. Ces plateformes s'étendent maintenant pour prendre en charge les GPU AMD et travaillent sur des preuves au niveau des charges de travail pour garantir la performance.

Bittensor incite les validateurs et les exécutants de modèles grâce au token $TAO. L'apprentissage fédéré gagne en adoption, principalement dans le secteur de la santé et des finances, en permettant un entraînement collaboratif sans déplacer de données brutes sensibles.

La preuve d'inférence et l'apprentissage automatique à connaissance nulle permettent des sorties de modèle vérifiables même lorsqu'elles fonctionnent sur du matériel non fiable. Ce sont des étapes fondamentales pour des API d'IA décentralisées et sans confiance.

---

Où se trouve l'opportunité économique

À court terme (aujourd'hui à 18 mois), l'accent est mis sur l'infrastructure de couche d'application. Les outils qui permettent aux entreprises de passer facilement d'OpenAI, Anthropic, Mistral ou des modèles locaux à poids ouverts seront précieux. De même, les studios ajustés offrant des versions conformes aux réglementations des modèles ouverts sous des SLA d'entreprise gagnent en traction.

À moyen terme (18 mois à 5 ans), les réseaux GPU décentralisés devraient s'accélérer à mesure que leurs prix de token reflètent l'utilisation réelle. Pendant ce temps, les sous-réseaux de style Bittensor axés sur des tâches spécialisées, comme l'évaluation des risques ou le repliement des protéines, évolueront efficacement grâce aux effets de réseau.

À long terme (plus de 5 ans), l'IA en périphérie devrait dominer. Les téléphones, les voitures et les appareils IoT exécuteront des LLM locaux entraînés par apprentissage fédéré, réduisant la latence et la dépendance au cloud. Des protocoles de propriété des données émergeront également, permettant aux utilisateurs de gagner des micro-redevances à mesure que leurs appareils contribuent aux gradients des mises à jour de modèles globaux.

---

Comment identifier les gagnants

Les projets susceptibles de réussir auront un fossé technique solide, résolvant des problèmes autour de la bande passante, de la vérification ou de la confidentialité d'une manière qui offre des améliorations d'ordres de grandeur. Les roues économiques doivent être bien conçues. Une utilisation plus élevée devrait financer une meilleure infrastructure et des contributeurs, et non simplement subventionner les passagers clandestins.

La gouvernance est essentielle. Le vote par token seul est fragile, cherchez plutôt des conseils multi-parties prenantes, des chemins de décentralisation progressive ou des modèles de token à double classe.

Enfin, l'attraction de l'écosystème compte. Les protocoles qui s'intègrent tôt avec les chaînes d'outils des développeurs compenseront l'adoption plus rapidement.

---

Jeux stratégiques

Pour les investisseurs, il peut être judicieux de se couvrir, en maintenant une exposition à la fois aux API centralisées (pour des rendements stables) et aux tokens décentralisés (pour un potentiel asymétrique). Pour les bâtisseurs, les couches d'abstraction qui permettent un passage en temps réel entre les points de terminaison centralisés et décentralisés, en fonction de la latence, du coût ou de la conformité, représentent une opportunité à fort levier.

Les opportunités les plus précieuses pourraient ne pas se situer aux pôles mais dans le tissu conjonctif : protocoles, couches d'orchestration et preuves cryptographiques qui permettent aux charges de travail de circuler librement au sein des systèmes centralisés et décentralisés.

Merci de votre lecture !

967

18

Le contenu de cette page est fourni par des tiers. Sauf indication contraire, OKX n’est pas l’auteur du ou des articles cités et ne revendique aucun droit d’auteur sur le contenu. Le contenu est fourni à titre d’information uniquement et ne représente pas les opinions d’OKX. Il ne s’agit pas d’une approbation de quelque nature que ce soit et ne doit pas être considéré comme un conseil en investissement ou une sollicitation d’achat ou de vente d’actifs numériques. Dans la mesure où l’IA générative est utilisée pour fournir des résumés ou d’autres informations, ce contenu généré par IA peut être inexact ou incohérent. Veuillez lire l’article associé pour obtenir davantage de détails et d’informations. OKX n’est pas responsable du contenu hébergé sur des sites tiers. La détention d’actifs numériques, y compris les stablecoins et les NFT, implique un niveau de risque élevé et leur valeur peut considérablement fluctuer. Examinez soigneusement votre situation financière pour déterminer si le trading ou la détention d’actifs numériques vous convient.