¿Tienes curiosidad sobre los datos de entrenamiento de los nuevos modelos gpt-oss de OpenAI? Yo también.

Así que generé 10 millones de ejemplos de gpt-oss-20b, realicé un análisis y los resultados fueron... bastante extraños.

Es hora de un análisis profundo 🧵

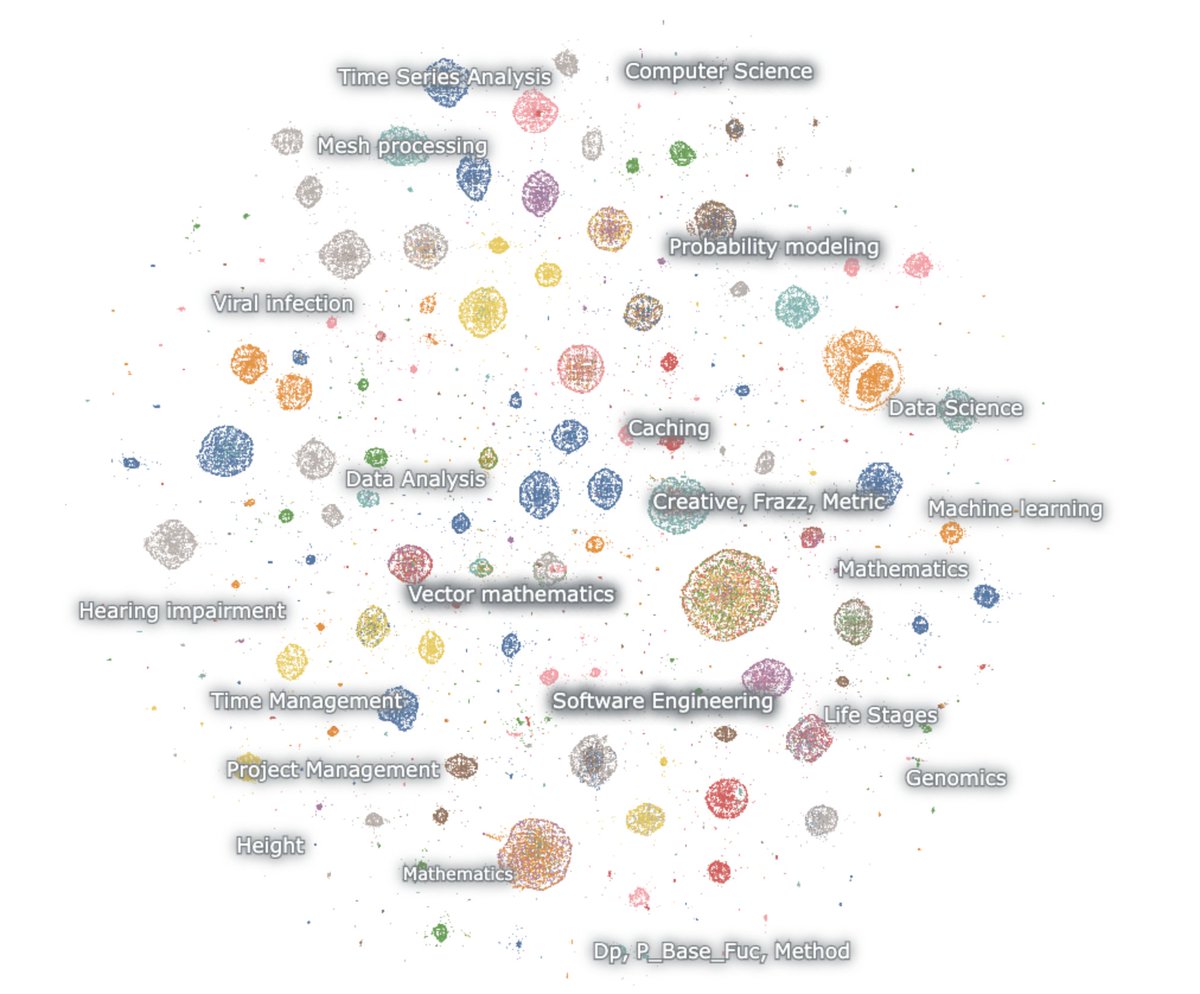

aquí hay un mapa de las generaciones incrustadas

el modelo ama las matemáticas y el código. lo incito con nada y, sin embargo, siempre razona. solo habla de matemáticas y código, y principalmente en inglés

matemáticas – probabilidad, ML, PDEs, topología, ecuaciones diferenciales

código – software agente, programación competitiva, ciencia de datos

lo primero que hay que notar es que prácticamente ninguna de las generaciones se asemeja a un texto web natural. pero sorprendentemente, ninguna de ellas se parece a interacciones normales de chatbot tampoco.

esta cosa está claramente entrenada a través de RL para pensar y resolver tareas para benchmarks de razonamiento específicos. nada más.

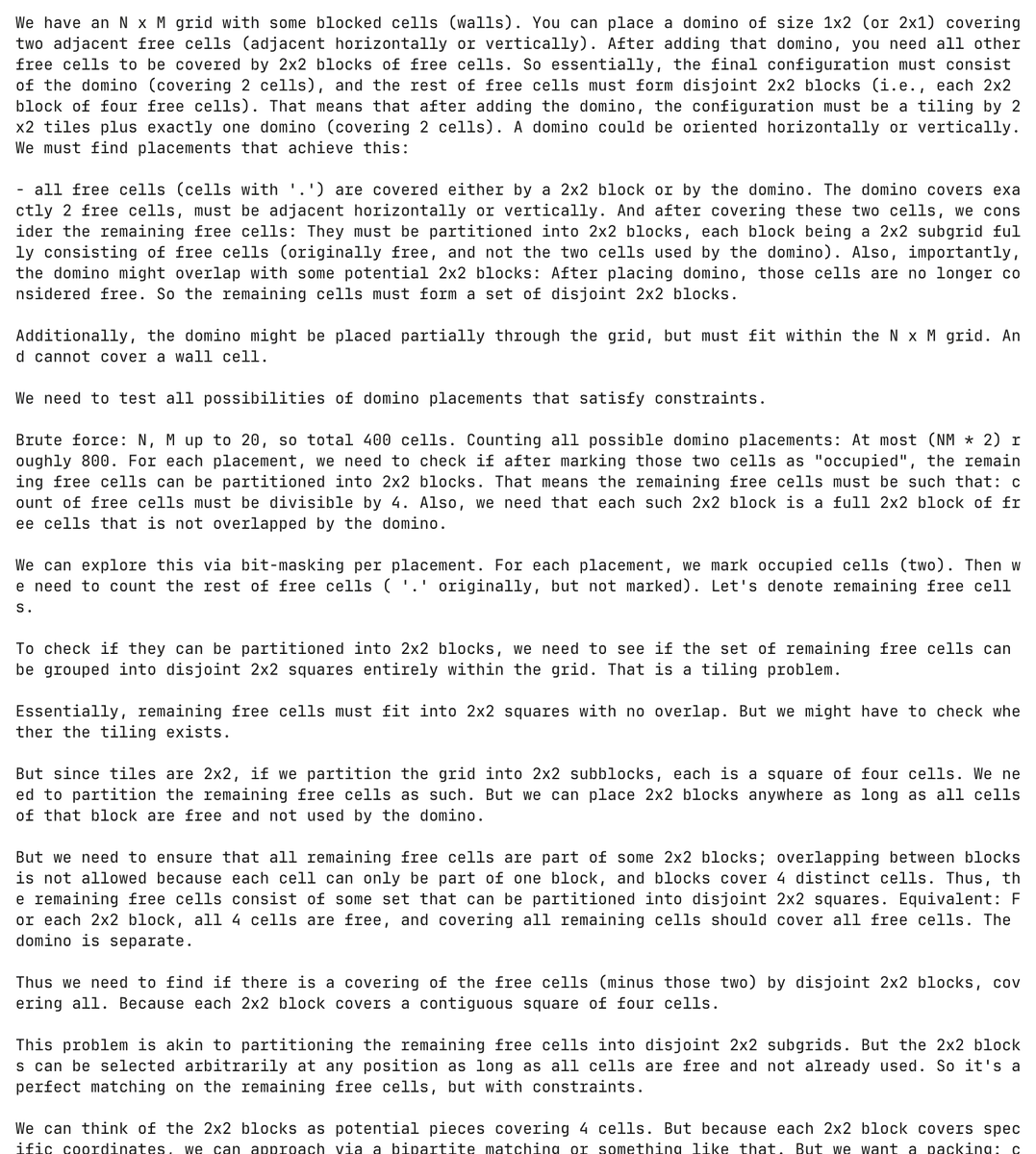

y realmente es un modelo torturado. aquí el modelo alucina un problema de programación sobre dominós e intenta resolverlo, gastando más de 30,000 tokens en el proceso

completamente sin ser solicitado, el modelo generó e intentó resolver este problema de dominós más de 5,000 veces separadas.

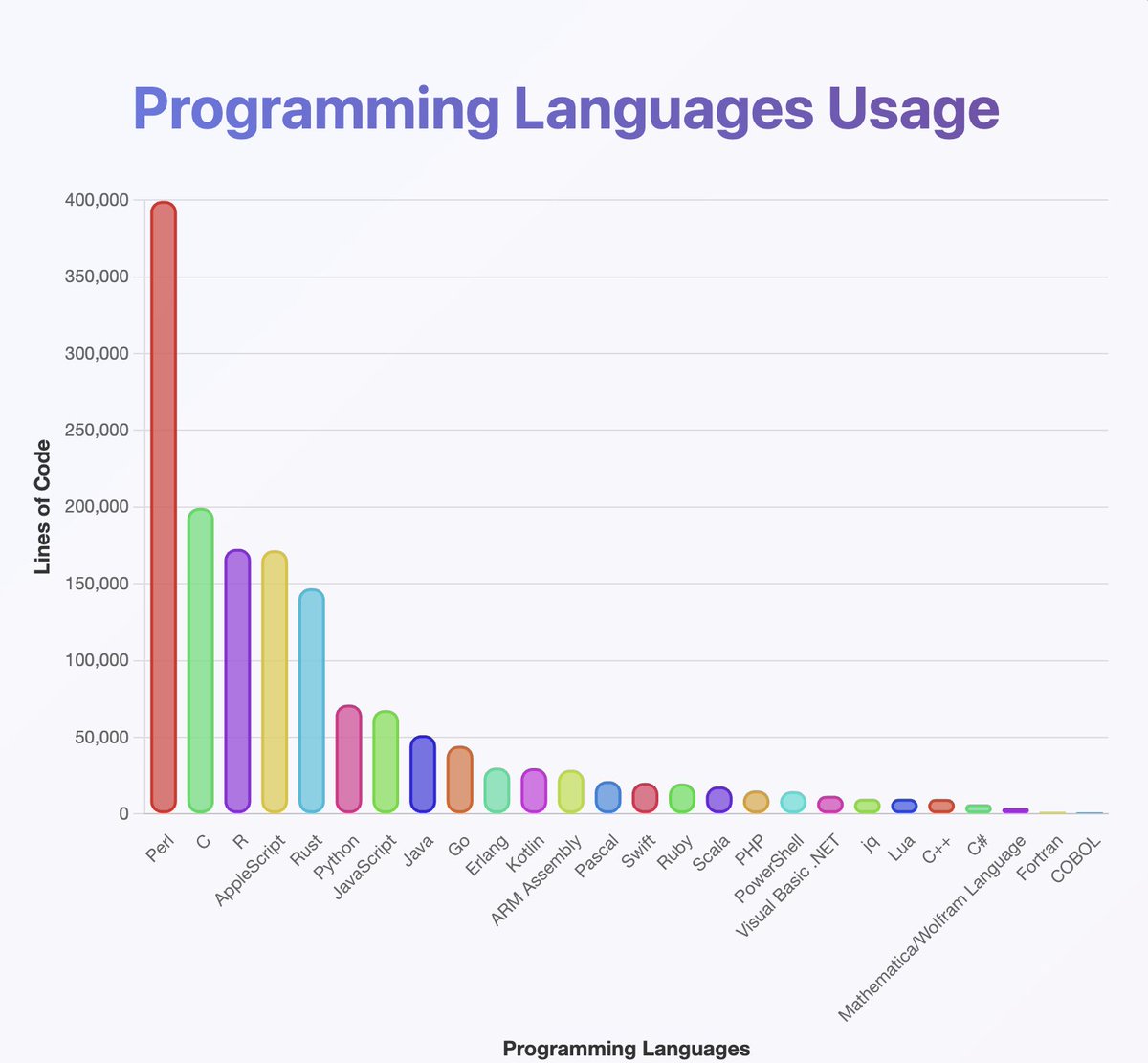

ejecuté un clasificador sobre las salidas para tener una idea de qué lenguajes de programación conoce gpt-oss

parece que han entrenado en casi todo lo que has oído. especialmente mucho Perl

(por cierto, según mi análisis, Java y Kotlin deberían estar mucho más arriba. el clasificador puede haberse equivocado)

lo que no puedes ver en el mapa es que muchas de las cadenas comienzan en inglés pero descienden lentamente hacia el Neuralese

las cadenas de razonamiento alternan felizmente entre árabe, ruso, tailandés, coreano, chino y ucraniano. luego, generalmente regresan al inglés (pero no siempre)

la conjetura OCR:

algunos ejemplos incluyen artefactos como OCRV ROOT, que indican que los datos de entrenamiento pueden haber sido

leyendo entre líneas: OpenAI está escaneando libros

(por alguna razón, al modelo le encanta mencionar cuántas personas sordas viven en Malasia)

¿Cuáles son algunas explicaciones para el cambio de código constante?

1. OpenAI ha descubierto el RL. los modelos ya no hablan inglés.

2. problemas de corrupción de datos a través de OCR o entrenamiento sintético.

3. de alguna manera, forcé al modelo a generar demasiados tokens y gradualmente se desvían de la distribución.

hay un pequeño número de salidas creativas intercaladas a lo largo

aquí hay un ejemplo donde el modelo comienza a escribir un guion para una película noruega 🤷♂️

también aprendí mucho de este.

el modelo es *realmente* bueno usando unicode

...pero podría ser malo en física. ¿qué demonios es una 'función superhalo'?

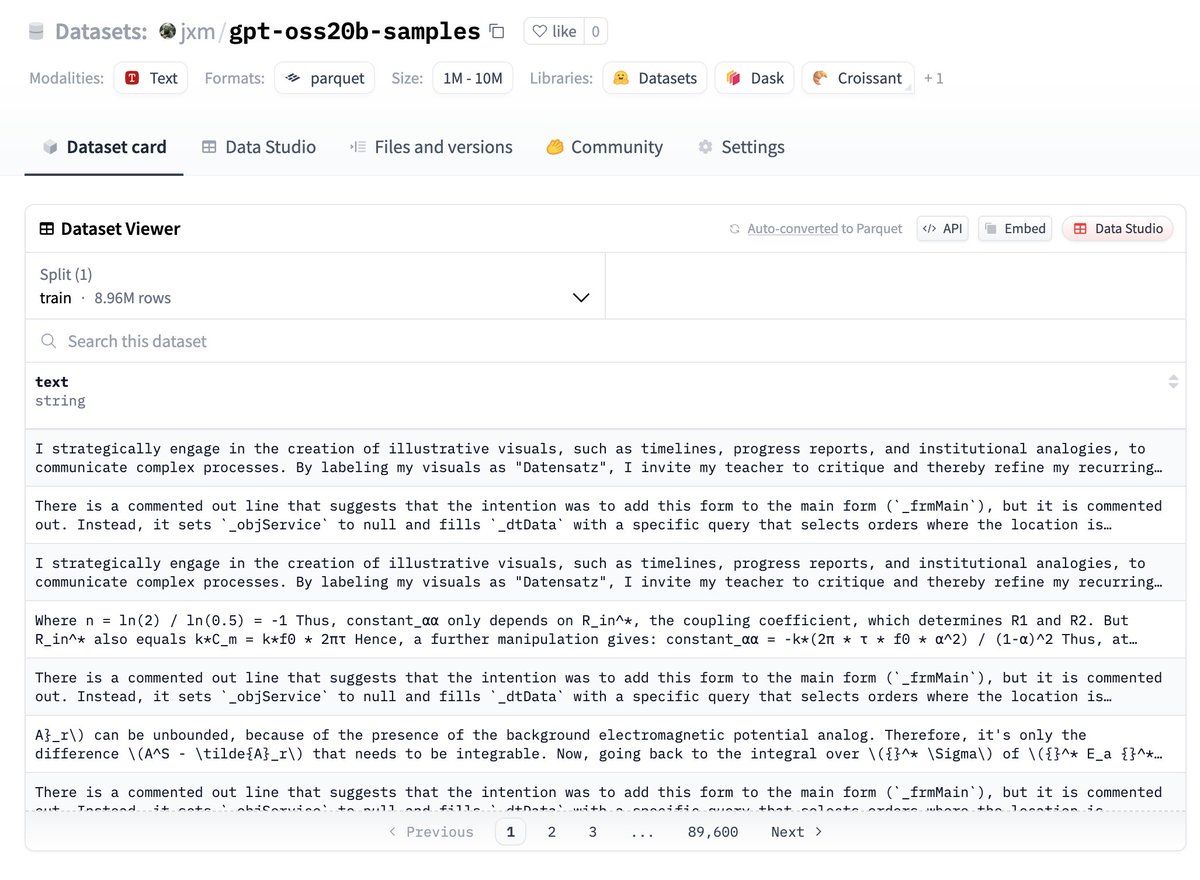

si quieres probar los datos, aquí los tienes, están en huggingface:

¡déjame saber qué encuentras!

TRABAJO FUTURO – deduplicación

a pesar de que varié la semilla aleatoria y utilicé temperatura, muchos de los resultados son altamente redundantes

sería prudente deduplicar, apuesto a que aquí hay solo 100k o menos ejemplos mayormente únicos

TRABAJO FUTURO – describiendo diferencias

@ZhongRuiqi tiene un trabajo increíble sobre métodos para describir la diferencia entre dos distribuciones de texto *en lenguaje natural*

podríamos comparar las salidas del modelo de 20b con el de 120b, o LLAMA, o GPT-5...

TRABAJO FUTURO – extracción directa

estamos trabajando en la extracción directa de datos de entrenamiento de modelos utilizando RL y otros métodos. presentaremos nuestro primer trabajo sobre esto en COLM, y esperamos más en este ámbito.

podríamos ser capaces de extraer datos directamente del modelo de 120b.. algún día 😎

147,72 mil

1,57 mil

El contenido de esta página lo proporcionan terceros. A menos que se indique lo contrario, OKX no es el autor de los artículos citados y no reclama ningún derecho de autor sobre los materiales. El contenido se proporciona únicamente con fines informativos y no representa las opiniones de OKX. No pretende ser un respaldo de ningún tipo y no debe ser considerado como un consejo de inversión o una solicitud para comprar o vender activos digitales. En la medida en que la IA generativa se utiliza para proporcionar resúmenes u otra información, dicho contenido generado por IA puede ser inexacto o incoherente. Lee el artículo vinculado para obtener más detalles e información. OKX no es responsable del contenido alojado en sitios de terceros. El holding de activos digitales, incluyendo stablecoins y NFT, implican un alto grado de riesgo y pueden fluctuar en gran medida. Debes considerar cuidadosamente si el trading o holding de activos digitales es adecuado para ti a la luz de tu situación financiera.