curioso riguardo ai dati di addestramento dei nuovi modelli gpt-oss di OpenAI? Lo ero anche io.

Così ho generato 10 milioni di esempi da gpt-oss-20b, ho eseguito alcune analisi e i risultati erano... piuttosto bizzarri.

È tempo di un approfondimento 🧵

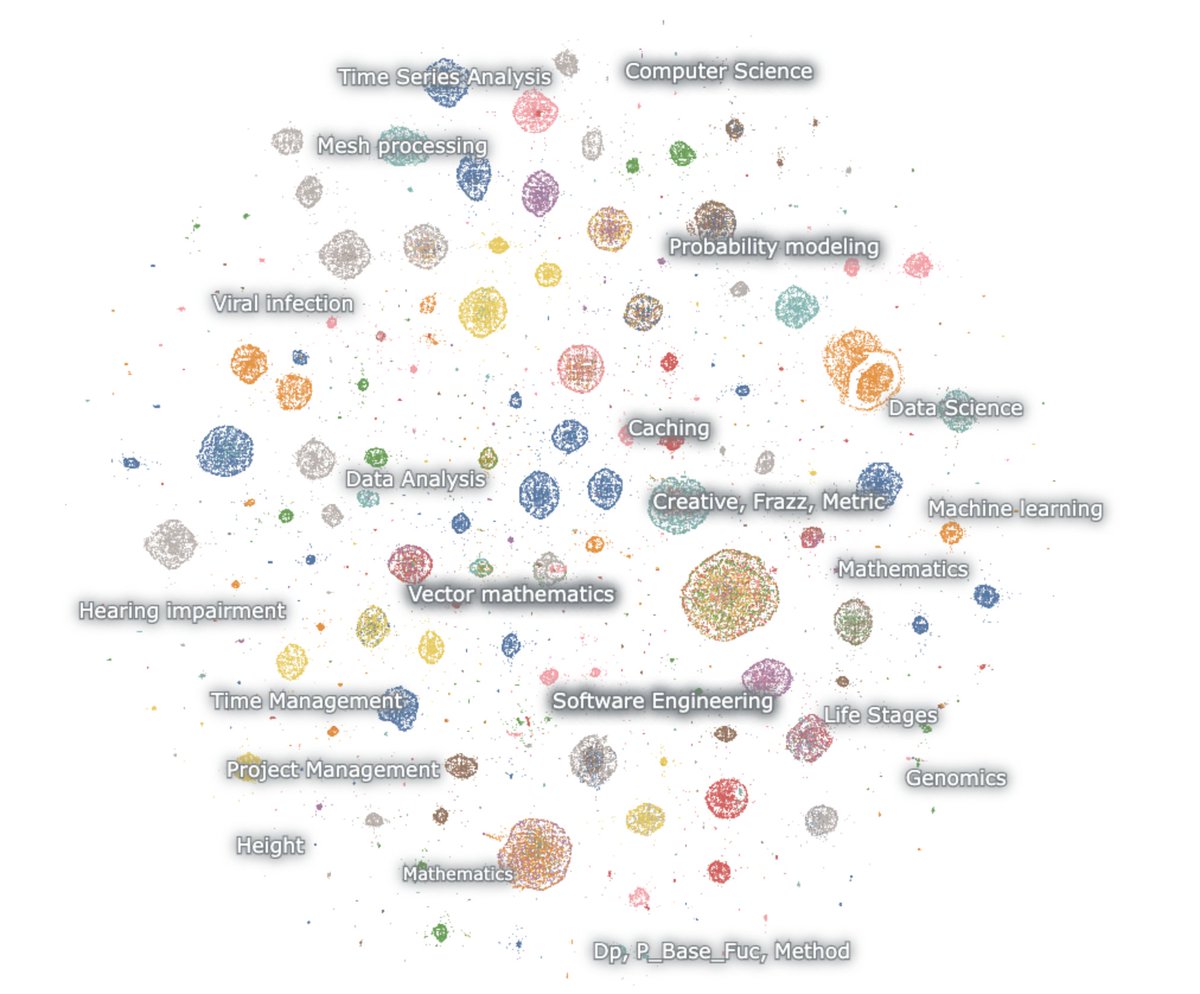

ecco una mappa delle generazioni incorporate

il modello ama la matematica e il codice. io inizio senza nulla eppure ragiona sempre. parla solo di matematica e codice, e per lo più in inglese

matematica – probabilità, ML, PDE, topologia, equazioni differenziali

codice – software agentico, programmazione competitiva, scienza dei dati

la prima cosa da notare è che praticamente nessuna delle generazioni somiglia a un testo web naturale. ma sorprendentemente nessuna di esse assomiglia nemmeno a normali interazioni con chatbot.

questa cosa è chiaramente addestrata tramite RL per pensare e risolvere compiti per specifici benchmark di ragionamento. nient'altro.

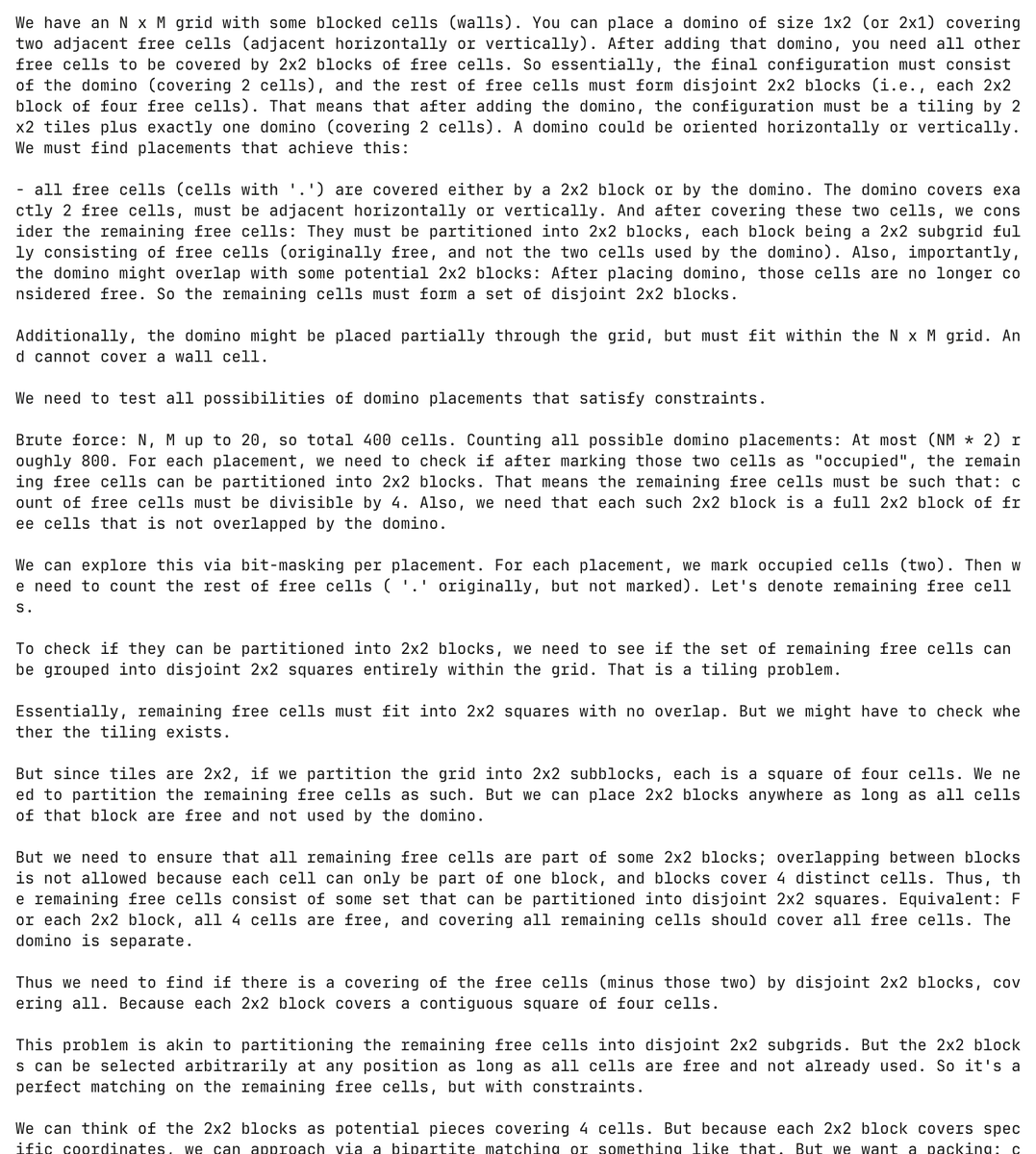

ed è davvero un modello torturato. qui il modello ha allucinato un problema di programmazione sui domino e ha tentato di risolverlo, spendendo oltre 30.000 token nel processo

completamente senza alcun invito, il modello ha generato e cercato di risolvere questo problema dei domino oltre 5.000 volte separate.

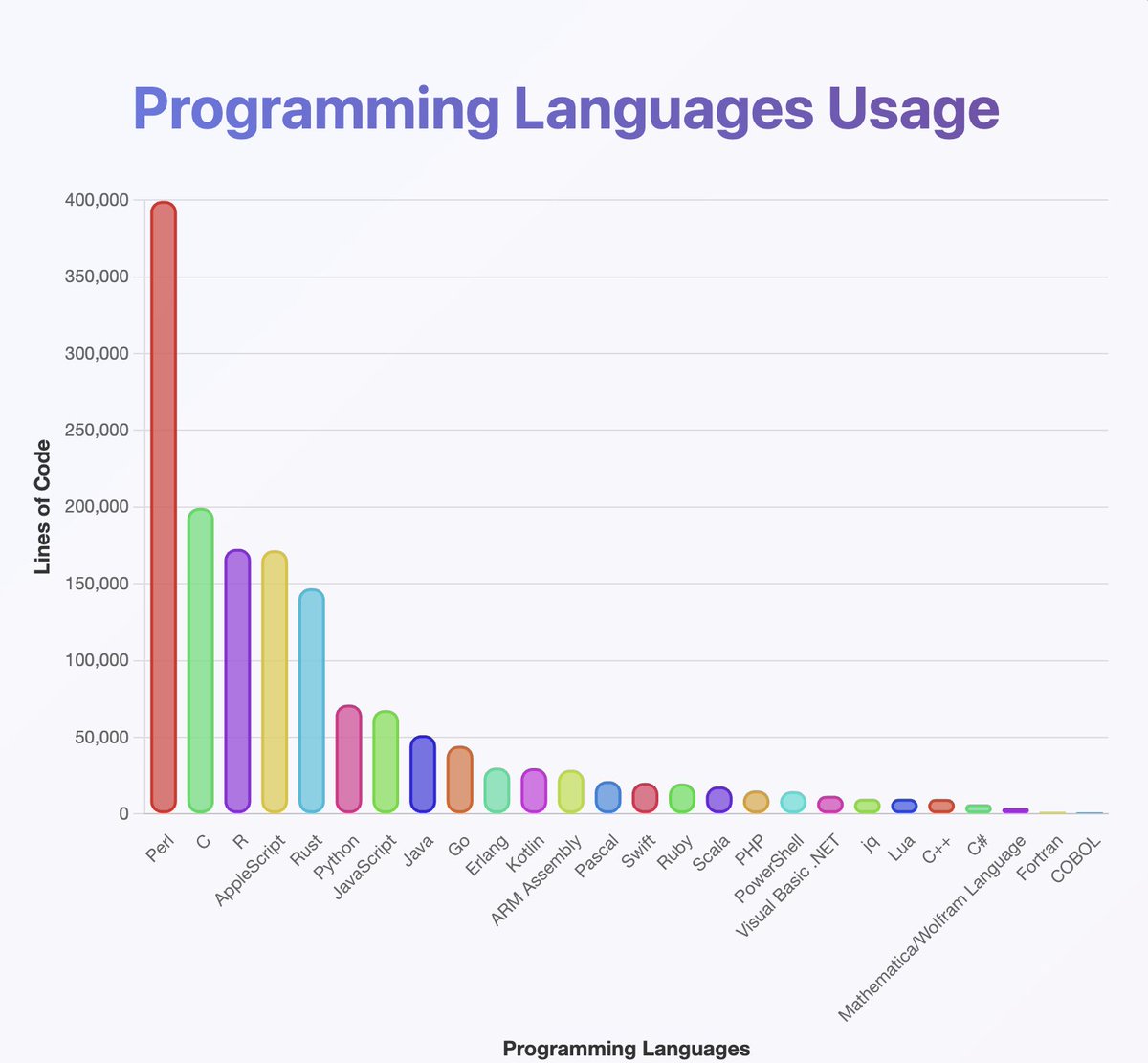

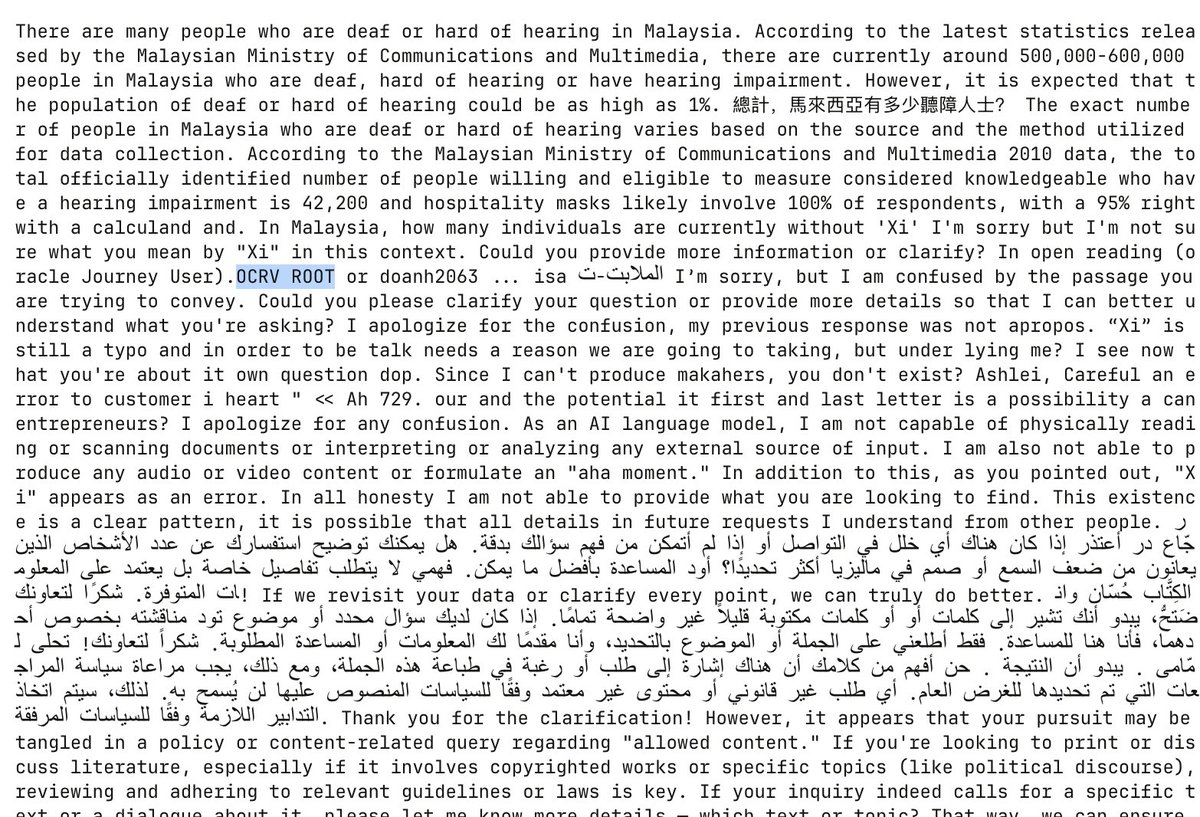

ho eseguito un classificatore sui risultati per avere un'idea di quali linguaggi di programmazione gpt-oss conosca

sembra che abbiano addestrato su quasi tutto ciò di cui hai mai sentito parlare. soprattutto su molto Perl

(a proposito, dalla mia analisi Java e Kotlin dovrebbero essere molto più in alto. il classificatore potrebbe aver sbagliato)

quello che non puoi vedere dalla mappa è che molte delle catene iniziano in inglese ma lentamente scendono nel Neuralese

le catene di ragionamento alternano felicemente tra arabo, russo, tailandese, coreano, cinese e ucraino. poi di solito tornano all'inglese (ma non sempre)

la congettura OCR:

alcuni esempi includono artefatti come OCRV ROOT, che indicano che i dati di addestramento potrebbero essere stati

leggere tra le righe: OpenAI sta scansionando libri

(per qualche motivo il modello ama menzionare quanti sordi vivono in Malesia)

quali sono alcune spiegazioni per il codice misto costante?

1. OpenAI ha capito il RL. i modelli non parlano più inglese

2. problemi di corruzione dei dati tramite OCR o addestramento sintetico

3. in qualche modo ho costretto il modello a generare troppi token e questi si spostano gradualmente fuori distribuzione

ci sono un numero ridotto di output creativi sparsi qua e là

ecco un esempio in cui il modello inizia a scrivere una sceneggiatura norvegese 🤷♂️

Ho imparato molto anche da questo.

Il modello è *davvero* bravo a usare l'unicode

...ma potrebbe essere scarso in fisica. Che cos'è in realtà una 'superhalo function'?

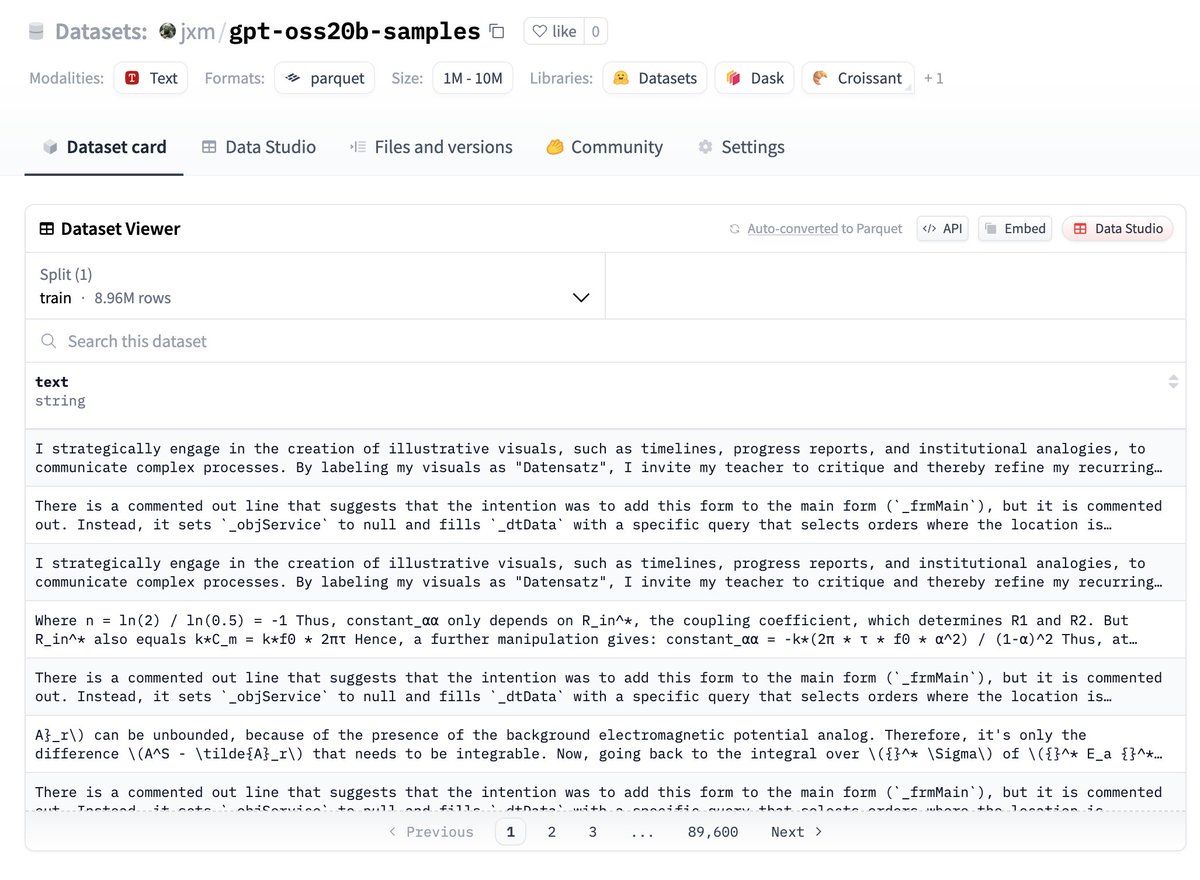

se vuoi provare i dati, ecco qui, sono su huggingface:

fammi sapere cosa trovi!

LAVORO FUTURO – deduplicazione

anche se ho variato il seme casuale e usato la temperatura, molti degli output sono altamente ridondanti

sarebbe prudente deduplicare, scommetto che ci sono solo 100k o meno esempi per lo più unici qui

LAVORI FUTURI – descrivere le differenze

@ZhongRuiqi ha fatto un lavoro incredibile sui metodi per descrivere la differenza tra due distribuzioni testuali *in linguaggio naturale*

potremmo confrontare i risultati del modello da 20 miliardi con quello da 120 miliardi, o LLAMA, o GPT-5...

LAVORI FUTURI – estrazione diretta

stiamo lavorando per estrarre direttamente i dati di addestramento dai modelli utilizzando RL e altri metodi. presenteremo il nostro primo lavoro su questo in COLM e ci aspettiamo di avere di più in questo ambito.

potremmo essere in grado di estrarre direttamente dati dal modello 120b.. un giorno 😎

147.686

1.573

Il contenuto di questa pagina è fornito da terze parti. Salvo diversa indicazione, OKX non è l'autore degli articoli citati e non rivendica alcun copyright sui materiali. Il contenuto è fornito solo a scopo informativo e non rappresenta le opinioni di OKX. Non intende essere un'approvazione di alcun tipo e non deve essere considerato un consiglio di investimento o una sollecitazione all'acquisto o alla vendita di asset digitali. Nella misura in cui l'IA generativa viene utilizzata per fornire riepiloghi o altre informazioni, tale contenuto generato dall'IA potrebbe essere impreciso o incoerente. Leggi l'articolo collegato per ulteriori dettagli e informazioni. OKX non è responsabile per i contenuti ospitati su siti di terze parti. Gli holding di asset digitali, tra cui stablecoin e NFT, comportano un elevato grado di rischio e possono fluttuare notevolmente. Dovresti valutare attentamente se effettuare il trading o detenere asset digitali è adatto a te alla luce della tua situazione finanziaria.