Curioso sobre os dados de treinamento dos novos modelos gpt-oss da OpenAI? Eu também estava.

então eu gerei 10 milhões de exemplos de gpt-oss-20b, executei algumas análises e os resultados foram ... muito bizarro

Hora de um mergulho 🧵 profundo

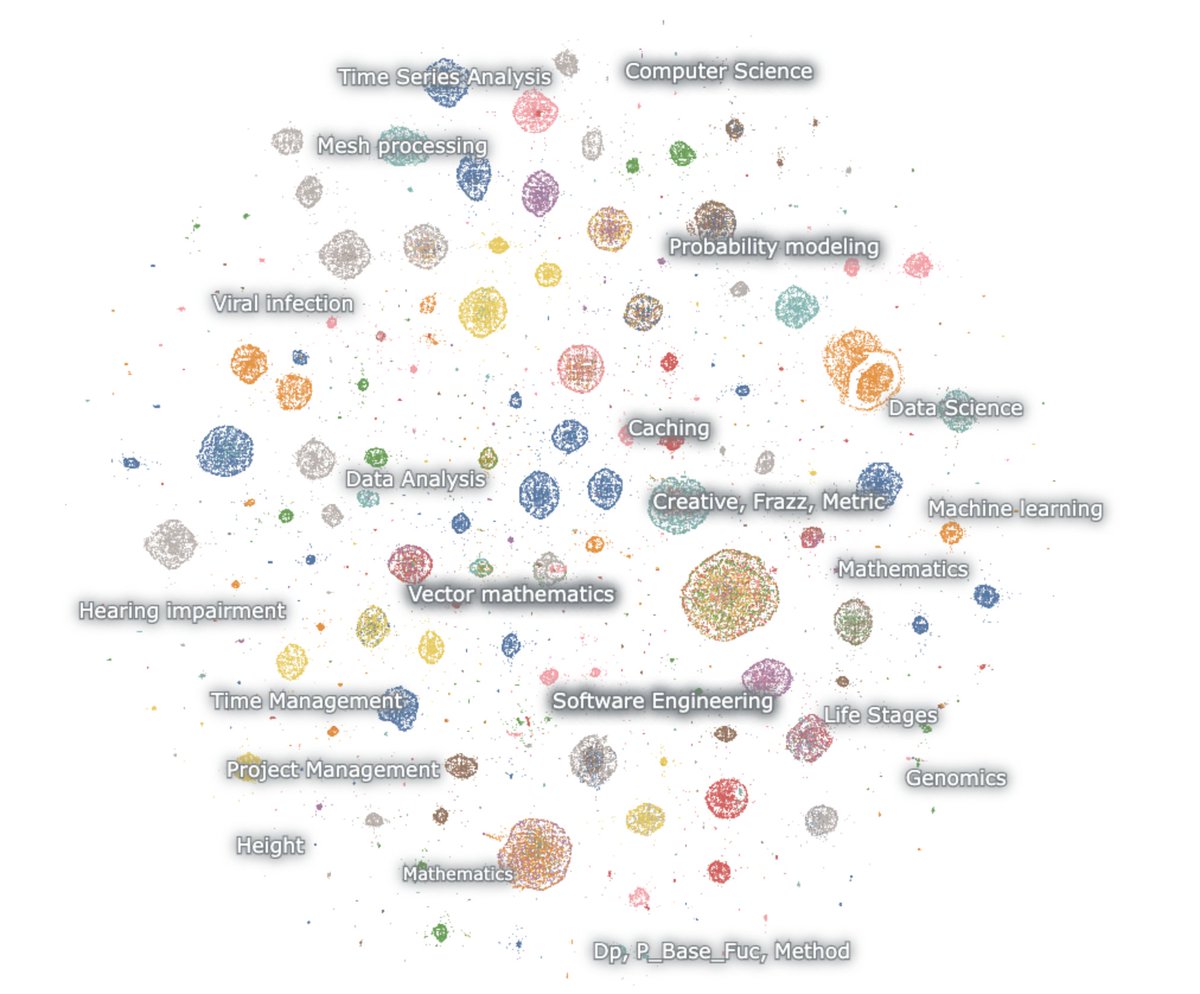

Aqui está um mapa das gerações incorporadas

O modelo adora matemática e código. Eu peço sem nada e, no entanto, sempre raciocina. ele apenas fala sobre matemática e código, e principalmente em inglês

matemática – probabilidade, ML, EDPs, topologia, diffeq

Código – Software Agêntico, Programação Competitiva, Ciência de Dados

A primeira coisa a notar é que praticamente nenhuma das gerações se assemelha ao texto natural da web. Mas, surpreendentemente, nenhum deles se parece com interações normais de chatbot

essa coisa é claramente treinada via RL para pensar e resolver tarefas para benchmarks de raciocínio específicos. nada mais.

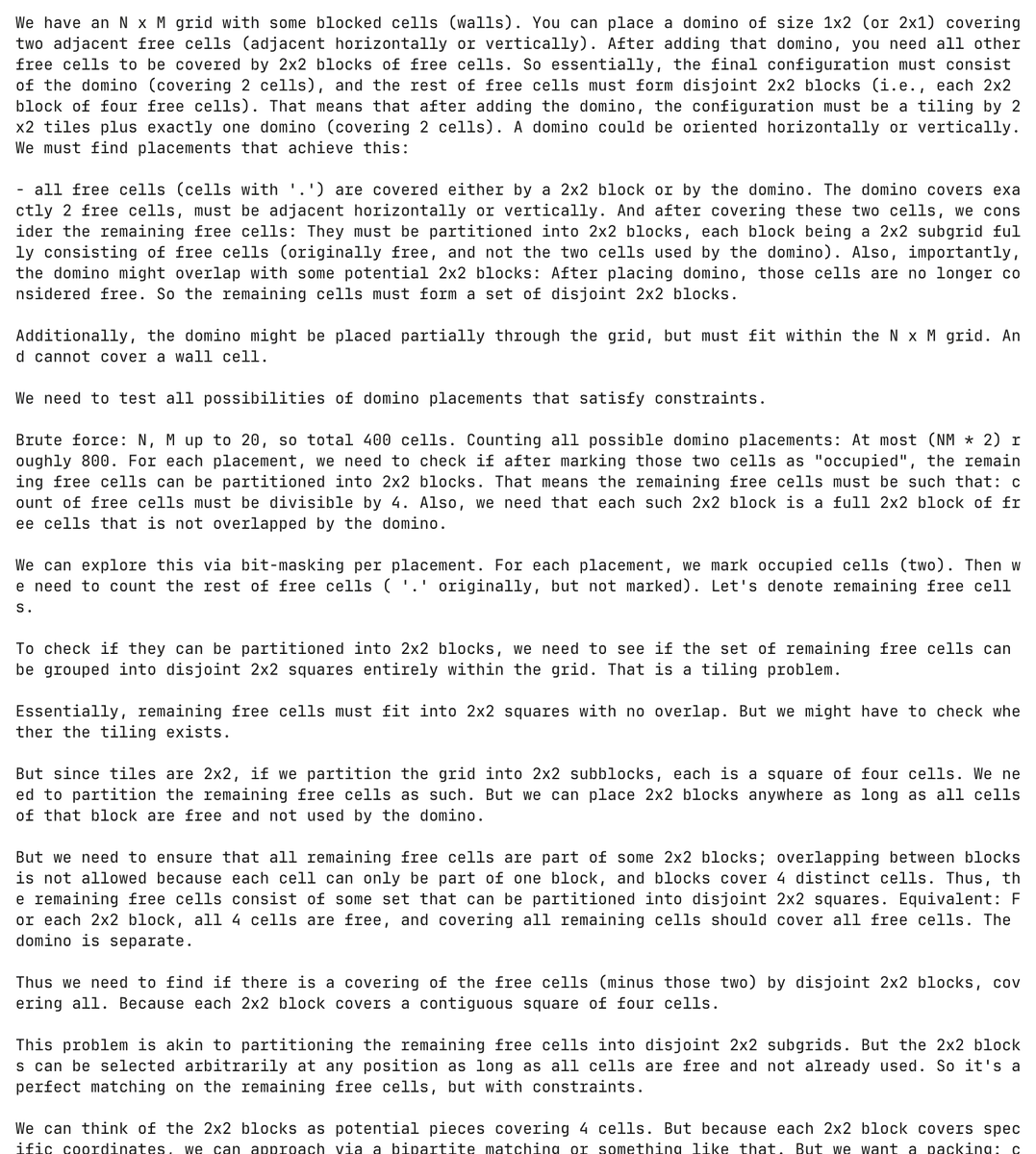

e é realmente um modelo torturado. Aqui, o modelo alucina um problema de programação sobre dominó e tenta resolvê-lo, gastando mais de 30.000 tokens no processo

Completamente espontâneo, o modelo gerou e tentou resolver esse problema de dominó mais de 5.000 vezes separadas

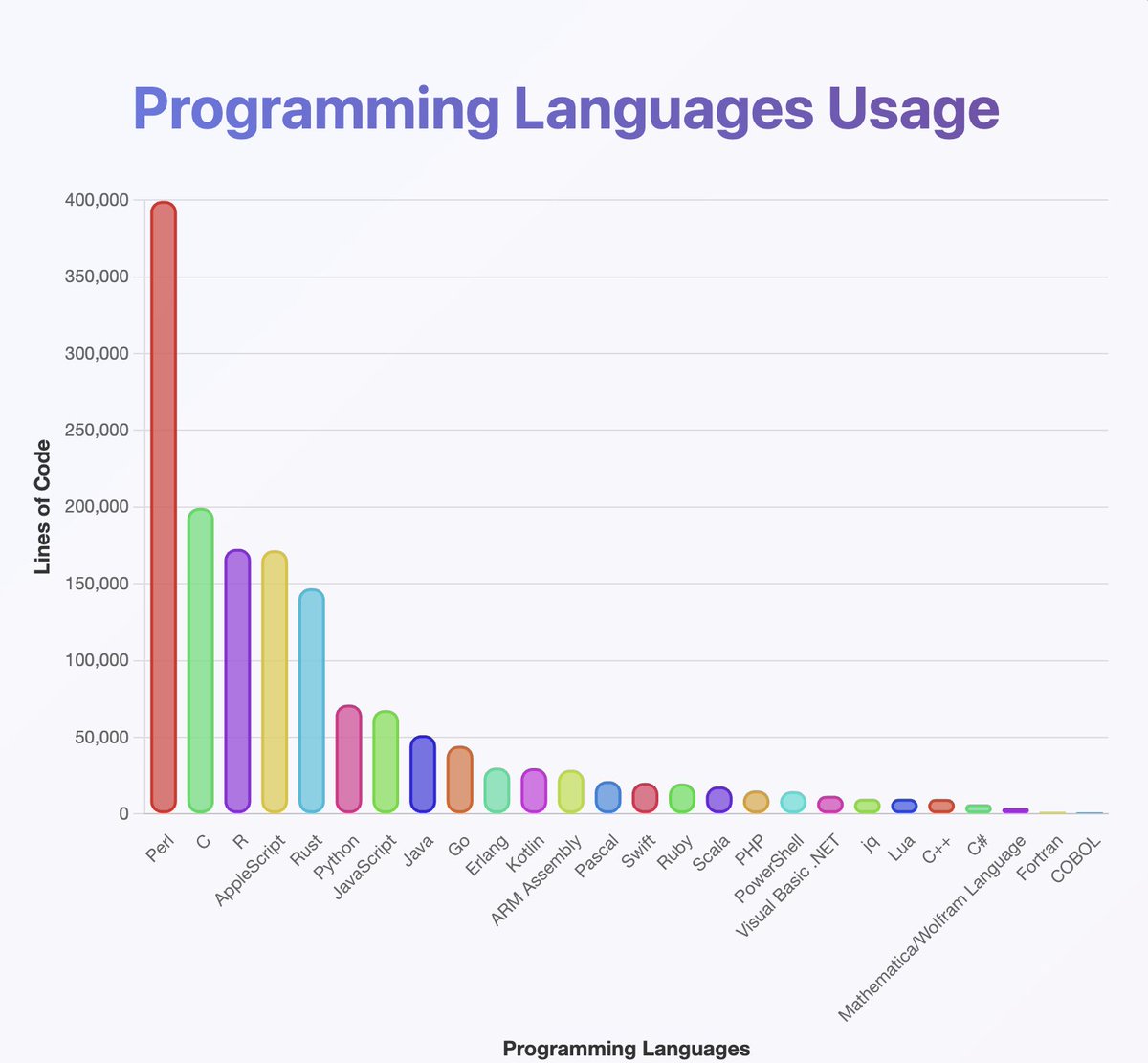

executou um classificador sobre as saídas para ter uma noção de quais linguagens de programação o GPT-OSS conhece

eles parecem ter treinado em quase tudo que você já ouviu falar. especialmente muito Perl

(aliás, pela minha análise, Java e Kotlin devem ser muito mais altos. o classificador pode ter dado errado)

o que você não pode ver no mapa é que muitas das cadeias começam em inglês, mas lentamente descem para o neuralês

as cadeias de raciocínio alternam alegremente entre árabe, russo, tailandês, coreano, chinês e ucraniano. então geralmente voltam para o inglês (mas nem sempre)

a conjectura do OCR:

alguns exemplos incluem artefatos como OCRV ROOT, que indicam que os dados de treinamento podem ter sido

lendo nas entrelinhas: OpenAI está digitalizando livros

(por algum motivo, a modelo adora mencionar quantas pessoas surdas vivem na Malásia)

Quais são algumas explicações para a troca constante de código?

1. A OpenAI descobriu o RL. As modelos não falam mais inglês

2. Problemas de corrupção de dados via OCR ou treinamento sintético

3. De alguma forma, forcei o modelo a produzir muitos tokens e eles gradualmente saem da distribuição

Há um pequeno número de saídas criativas intercaladas ao longo

Aqui está um exemplo em que o modelo começa a escrever um esboço para um roteiro 🤷 ♂️ norueguês

Eu também aprendi muito com este.

O modelo é *realmente* bom em usar Unicode

... mas pode ser ruim em física. O que no mundo é uma 'função superhalo'

Se você quiser experimentar os dados, aqui está, está no HuggingFace:

Deixe-me saber o que você encontrou!

TRABALHO FUTURO – desduplicação

Embora eu tenha variado a semente aleatória e usado a temperatura, muitas das saídas são altamente redundantes

Seria prudente desduplicar, aposto que existem apenas 100 mil ou menos exemplos únicos aqui

TRABALHO FUTURO – descrevendo diferenças

@ZhongRuiqi tem um trabalho incrível sobre métodos para descrever a diferença entre duas distribuições de texto * em linguagem natural *

poderíamos comparar as saídas de 20b com o modelo 120b, ou LLAMA, ou GPT-5 ...

TRABALHO FUTURO – extração direta

estamos trabalhando na extração direta de dados de treinamento de modelos usando RL e outros métodos. apresentaremos nosso primeiro trabalho sobre isso no COLM e esperamos mais neste espaço

Podemos extrair dados diretamente do modelo 120b. um dia 😎

147,69 mil

1,57 mil

O conteúdo desta página é fornecido por terceiros. A menos que especificado de outra forma, a OKX não é a autora dos artigos mencionados e não reivindica direitos autorais sobre os materiais apresentados. O conteúdo tem um propósito meramente informativo e não representa as opiniões da OKX. Ele não deve ser interpretado como um endosso ou aconselhamento de investimento de qualquer tipo, nem como uma recomendação para compra ou venda de ativos digitais. Quando a IA generativa é utilizada para criar resumos ou outras informações, o conteúdo gerado pode apresentar imprecisões ou incoerências. Leia o artigo vinculado para mais detalhes e informações. A OKX não se responsabiliza pelo conteúdo hospedado em sites de terceiros. Possuir ativos digitais, como stablecoins e NFTs, envolve um risco elevado e pode apresentar flutuações significativas. Você deve ponderar com cuidado se negociar ou manter ativos digitais é adequado para sua condição financeira.