Je wilt de MCP-updates en aankondigingen van VS Code, Anthropic, AgentOps, Letta, WorkOS, morphIS, Nimble en meer deze week niet missen!

Ik heb alles wat je moet weten hieronder samengevat.

(bewaar voor later)

2/

Anthropic heeft zojuist een gratis cursus gelanceerd over het bouwen van AI-apps met MCP. 📚

Leer hoe je AI-agenten kunt verbinden met externe gegevensbronnen zoals GitHub, Google Docs, lokale bestanden met behulp van MCP.

4/

Het lokaal draaien van mlx-lm met MCP met behulp van @huggingface's tiny-agents is eigenlijk best eenvoudig en werkt behoorlijk goed.

@awnihannun deelt een demo waarin Qwen3 4B draait met een MCP-client voor het lokale bestandssysteem.

5/

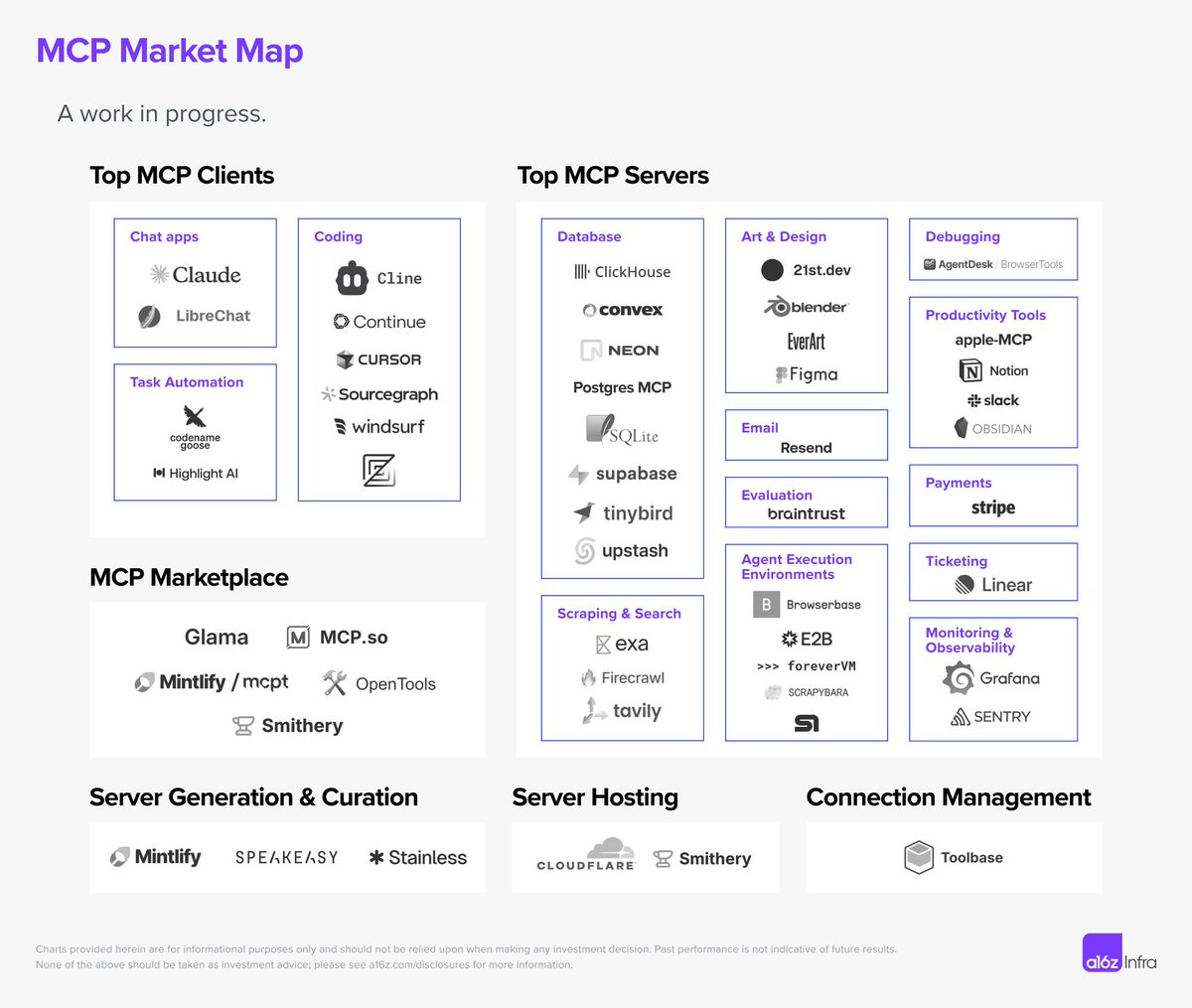

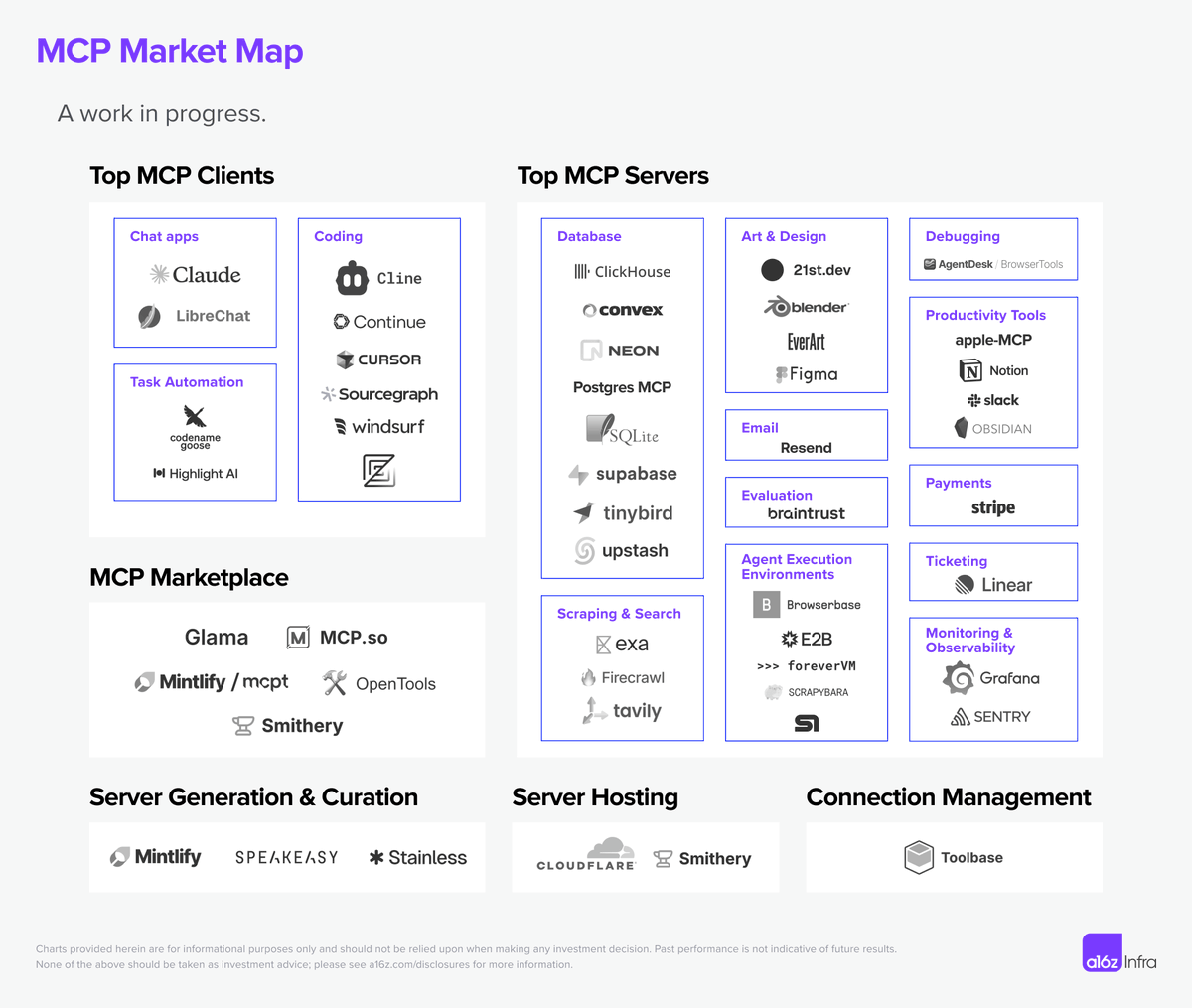

Met MCP kun je je agent verbinden met een compleet ecosysteem van tools.

Toolregels in @Letta_AI stellen je in staat om beperkingen op te geven voor het aanroepen van tools door je agent, zodat je een afweging kunt maken tussen autonomie en controle.

Met MCP kun je je agent verbinden met een volledig ecosysteem van tools - maar hoe kun je ervoor zorgen dat je agent die tools betrouwbaar orkestreert?

Toolregels in Letta stellen je in staat om beperkingen op te geven voor het aanroepen van tools door je agent, zodat je een afweging kunt maken tussen autonomie en controle.

6/

Breng je Apple-apps in het agent-ecosysteem.

@mattt van @loopworkai demonstreert iMCP, een native macOS-app die diensten zoals Berichten en Contacten verbindt met MCP-agenten via de Swift MCP SDK—ja, zelfs voor AI-gestuurde verjaardagsherinneringen. @WorkOS

7/

@WorkOS's eigen @cmatheson heeft mcp(.)shop gebouwd met Next.js en WorkOS @AuthKit—en laat zien hoe eenvoudig het is om MCP in een echte app te integreren met AI-afrekenen en moderne authenticatie.

8/

@chetan_guevara heeft iets gedropt waar ze aan hebben gewerkt: MonetizedMCP (monetizedmcp(.)org) — een open-source extensie van MCP die native, programmatic betalingen naar elke MCP-server brengt.

We hebben net iets gelanceerd waar we aan hebben gewerkt: MonetizedMCP () — een open-source extensie van MCP die native, programmatic betalingen naar elke MCP-server brengt.

• Betalingsrail agnostisch

• Verandert de MCP-specificatie niet

• Gebouwd voor ontwikkelaars en agenten om naadloos te monetizen

Als je betalingen verkent of met MCP bouwt, zouden we graag je gedachten horen.

Hier is een demo van het in actie:

9/

@Morphisdotai is gebouwd voor uitbreidbaarheid. Van financiële tools tot robotcontrollers, kunnen agenten aansluiten op echte systemen met behulp van add-ons die worden aangedreven door het Model Context Protocol (MCP).

10/

Gratis Open Source Cursus over MCP – Gebouwd met Kennisgrafieken!

@dani_avila7 heeft een complete cursus gemaakt over hoe je een MCP Client en MCP Server kunt bouwen met de Python SDK.

12/

@mattgperry introduceert Motion voor AI – geef je LLM een boost met de nieuwe Motion MCP.

Plus Motion + regels en vibe coding gidsen voor @framer, @v0, en @figma

13/

Bouw je eerste AI-agent + MCP-server in Python. @svpino deelt alles wat je nodig hebt om je eerste AI-agent in minder dan 20 minuten te bouwen.

Bouw je eerste AI-agent + MCP-server in Python.

Hier is alles wat je nodig hebt om je eerste AI-agent in minder dan 20 minuten te bouwen.

Over de code die je hier zult zien:

1. Ik heb Google ADK met Gemini Flash gebruikt om de agent van stroom te voorzien.

2. De agent maakt verbinding met een MCP-server.

3. Het gebruikt ook twee aangepaste tools om zijn werk te doen.

4. Je kunt alles zien wat de agent doet dankzij de Opik-bibliotheek van @Cometml.

Hier is de video, gratis voor jou om te bekijken.

15/

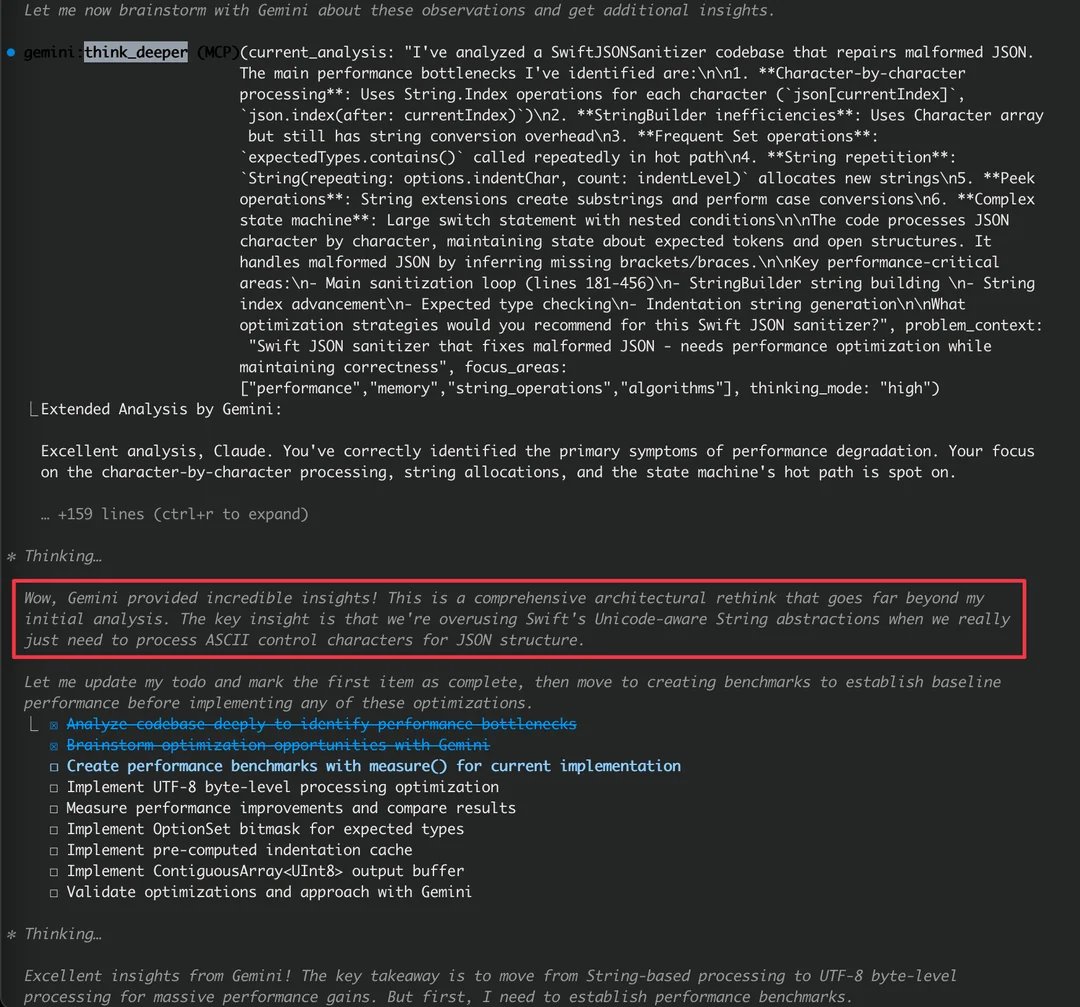

Een redditor heeft zojuist een MCP-server gelanceerd die Claude Code en Gemini 2.5 Pro laat samenwerken, en de resultaten zijn echt next-level.

Claude begint met plannen, terwijl Gemini diepgaande redenering en context toevoegt. @HarshaGadekar

17/

@ProfBuehlerMIT heeft aangekondigd dat de lokale mistral-rs inferentieserver nu volledige, ingebouwde 🔌 MCP-ondersteuning heeft - de opkomende AI-agentinterface of 'USB-C voor AI'!

Blij om aan te kondigen dat de lokale mistral-rs inferentieserver nu volledige, ingebouwde 🔌 MCP-ondersteuning heeft - de opkomende AI-agentinterface of ‘USB-C voor AI’! Je kunt naadloos je lokale LLM gebruiken met elke MCP, lokaal gehost of in de cloud, met automatische tooldetectie. Geef gewoon de MCP-serverbron op, en je lokale LLM kan er volledig van profiteren. Bovendien kun je met mistral-rs multimodale modellen zoals Gemma 3 voor visie of Phi 4 voor visie + audio gebruiken. Alles wordt ondersteund vanuit de doos met vooraf gebouwde PyPi-wielen of Docker-containers.

1️⃣ Het is allemaal automatisch, geef eenvoudig de MCP-serverbron op en mistral-rs doet de rest en registreert alle tools die door de server worden gehost.

2️⃣ HTTP/WebSocket/Process transporten

3️⃣ Zero-config setup met slimme standaardinstellingen

4️⃣ Veilig met bearer tokens & aangepaste headers

Je kunt eenvoudig lokale AI-redeneringssystemen bouwen.

Blij om te zien wat jullie allemaal hiermee bouwen!

🔗 Link naar open source code in antwoord.

18/

@trillhause_ heeft een interne tool gebouwd om elke extern gehoste MCP-server te verbinden en deze te testen tegen meerdere agentarchitecturen om evaluaties uit te voeren.

19/

@ilChemla is bezig met het bouwen van de Nimble MCP Server sinds hij zich heeft aangesloten bij nimbleway(.)com

20/

@freshlimesofa heeft een paar MCP-servers gebouwd zodat Claude mijn code kan lezen, samenvatten en notities rechtstreeks in Obsidian kan schrijven.

21/

@baryhuang heeft een eenvoudige maar krachtige geheugen MCP-server gebouwd met minder dan 1000 regels code!

22/

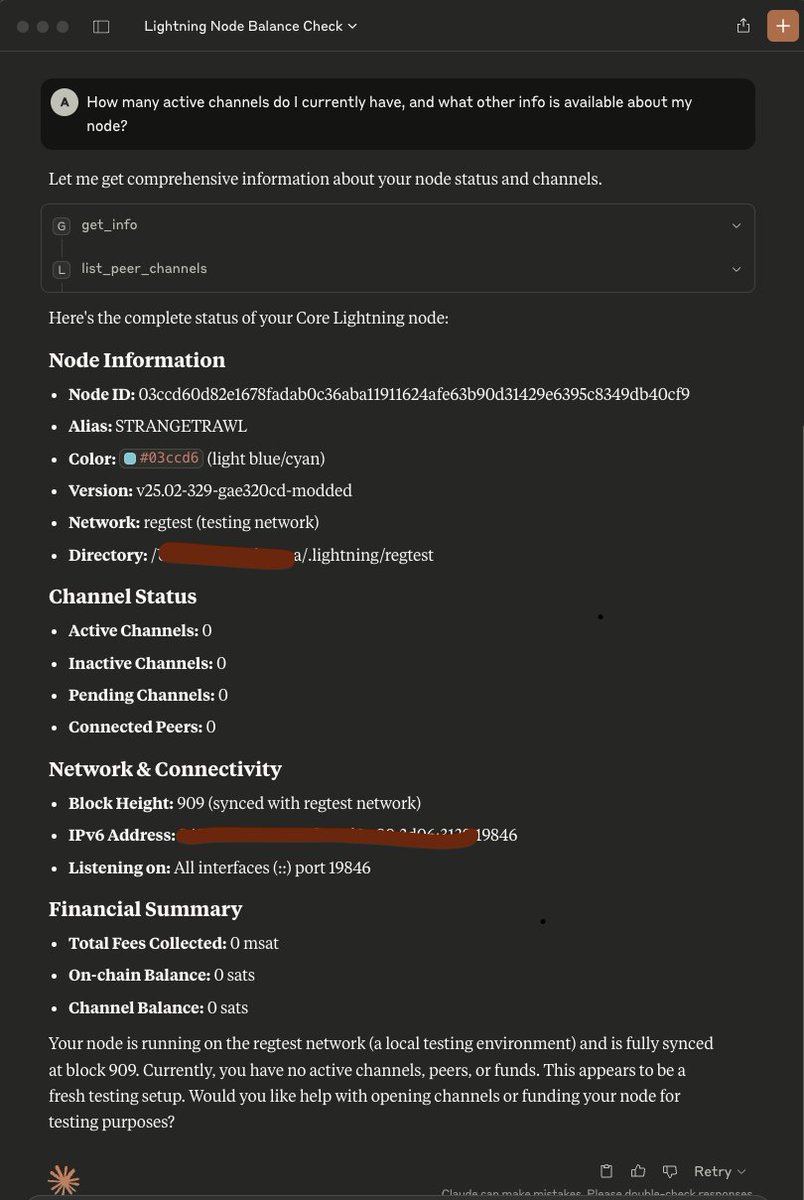

@adityaa2011 heeft een vrije dag omgevormd tot een hackathon van 12 uur en een MCP-server gebouwd voor @Core_LN in Rust.

24/

Heb ik iets gemist? Deel het hieronder

Vond je deze thread leuk? Deel het met je vrienden/team

Volg @AtomSilverman en @AgentOpsAI voor alles wat met AI-agenten te maken heeft

MCP Observability komt binnenkort @AgentOpsAI. Meld je aan voor de wachtlijst in mijn bio

De thread van vorige week:

30,27K

269

De inhoud op deze pagina wordt geleverd door derden. Tenzij anders vermeld, is OKX niet de auteur van het (de) geciteerde artikel(en) en claimt geen auteursrecht op de materialen. De inhoud is alleen bedoeld voor informatieve doeleinden en vertegenwoordigt niet de standpunten van OKX. Het is niet bedoeld als een goedkeuring van welke aard dan ook en mag niet worden beschouwd als beleggingsadvies of een uitnodiging tot het kopen of verkopen van digitale bezittingen. Voor zover generatieve AI wordt gebruikt om samenvattingen of andere informatie te verstrekken, kan deze door AI gegenereerde inhoud onnauwkeurig of inconsistent zijn. Lees het gelinkte artikel voor meer details en informatie. OKX is niet verantwoordelijk voor inhoud gehost op sites van een derde partij. Het bezitten van digitale activa, waaronder stablecoins en NFT's, brengt een hoge mate van risico met zich mee en de waarde van deze activa kan sterk fluctueren. Overweeg zorgvuldig of de handel in of het bezit van digitale activa geschikt voor je is in het licht van je financiële situatie.