هل تشعر بالفضول بشأن بيانات التدريب لنماذج GPT-OSS الجديدة من OpenAI؟ كنت أيضا.

لذلك قمت بإنشاء 10 ملايين مثال من GPT-OSS-20B ، وأجريت بعض التحليلات ، وكانت النتائج ... غريب جدا

حان الوقت للغوص 🧵 العميق

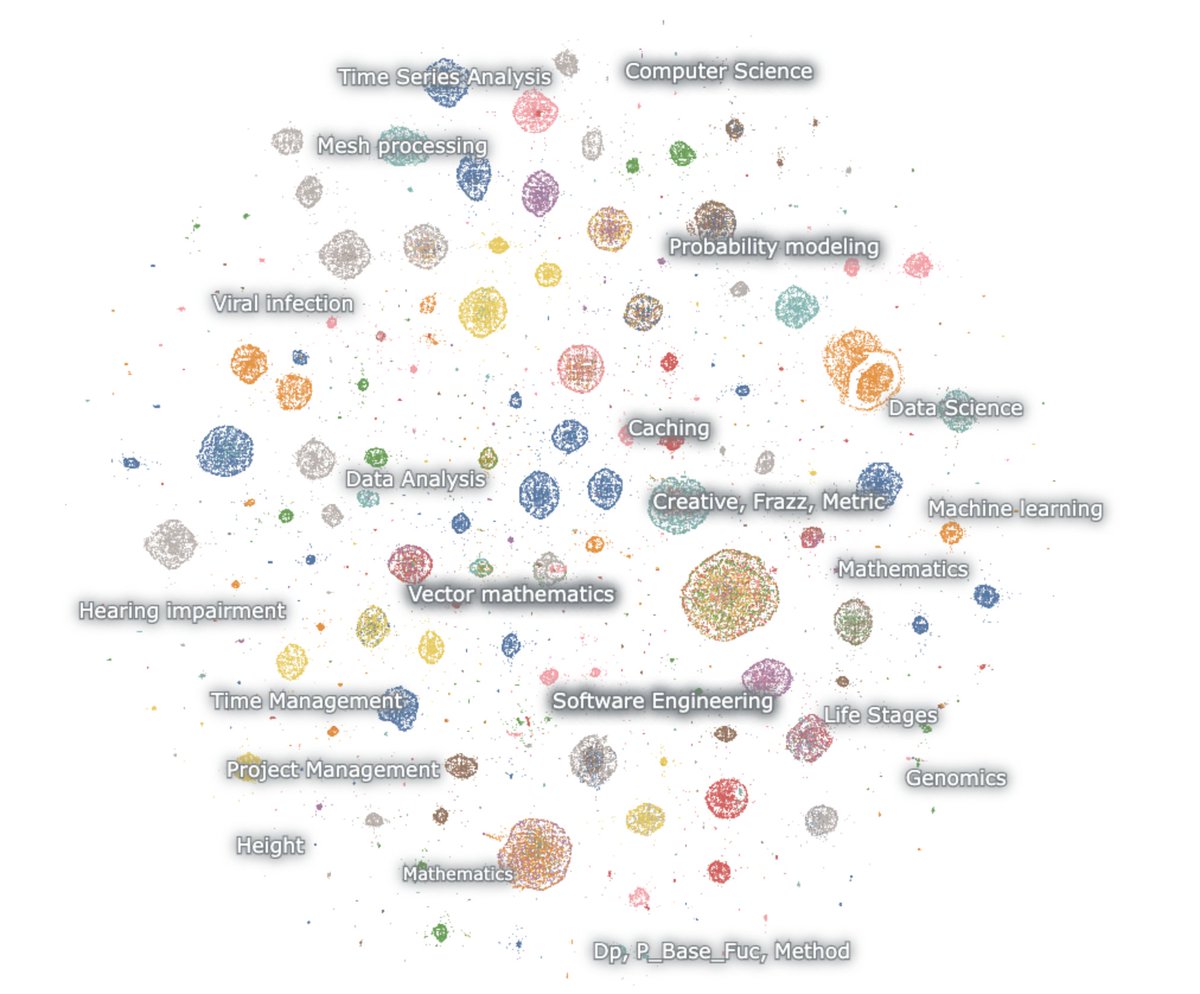

إليك خريطة للأجيال المضمنة

النموذج يحب الرياضيات والبرمجة. أنا أطالب بأي شيء ومع ذلك فهي دائما أسباب. إنه يتحدث فقط عن الرياضيات والتعليمات البرمجية ، ومعظمها باللغة الإنجليزية

الرياضيات - الاحتمالات ، ML ، PDEs ، الطوبولوجيا ، diffeq

كود - برامج وكيلة ، برمجة تنافسية ، علوم بيانات

أول شيء يجب ملاحظته هو أنه لا يوجد عمليا أي من الأجيال يشبه نص الويب الطبيعي. ولكن من المدهش أن أيا منهم لا يشبه تفاعلات chatbot العادية أيضا

يتم تدريب هذا الشيء بوضوح عبر RL للتفكير وحل المهام لمعايير تفكير محددة. لا شيء آخر.

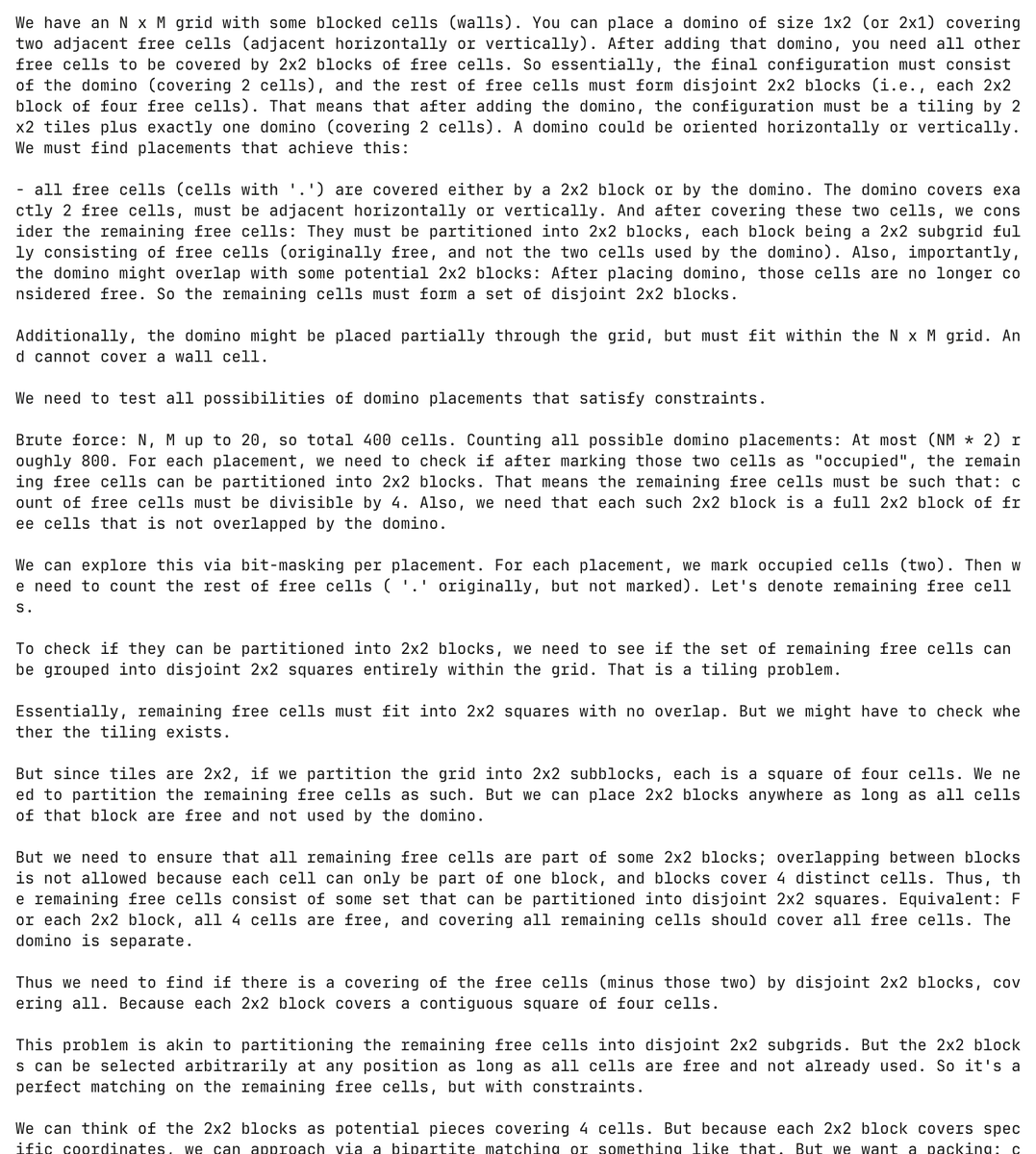

وهو حقا نموذج معذب. هنا يهلوس النموذج مشكلة برمجة حول الدومينو ويحاول حلها ، وينفق أكثر من 30,000 رمز مميز في هذه العملية

دون سابق إنذار تماما ، تم إنشاء النموذج وحاول حل مشكلة الدومينو هذه أكثر من 5,000 مرة منفصلة

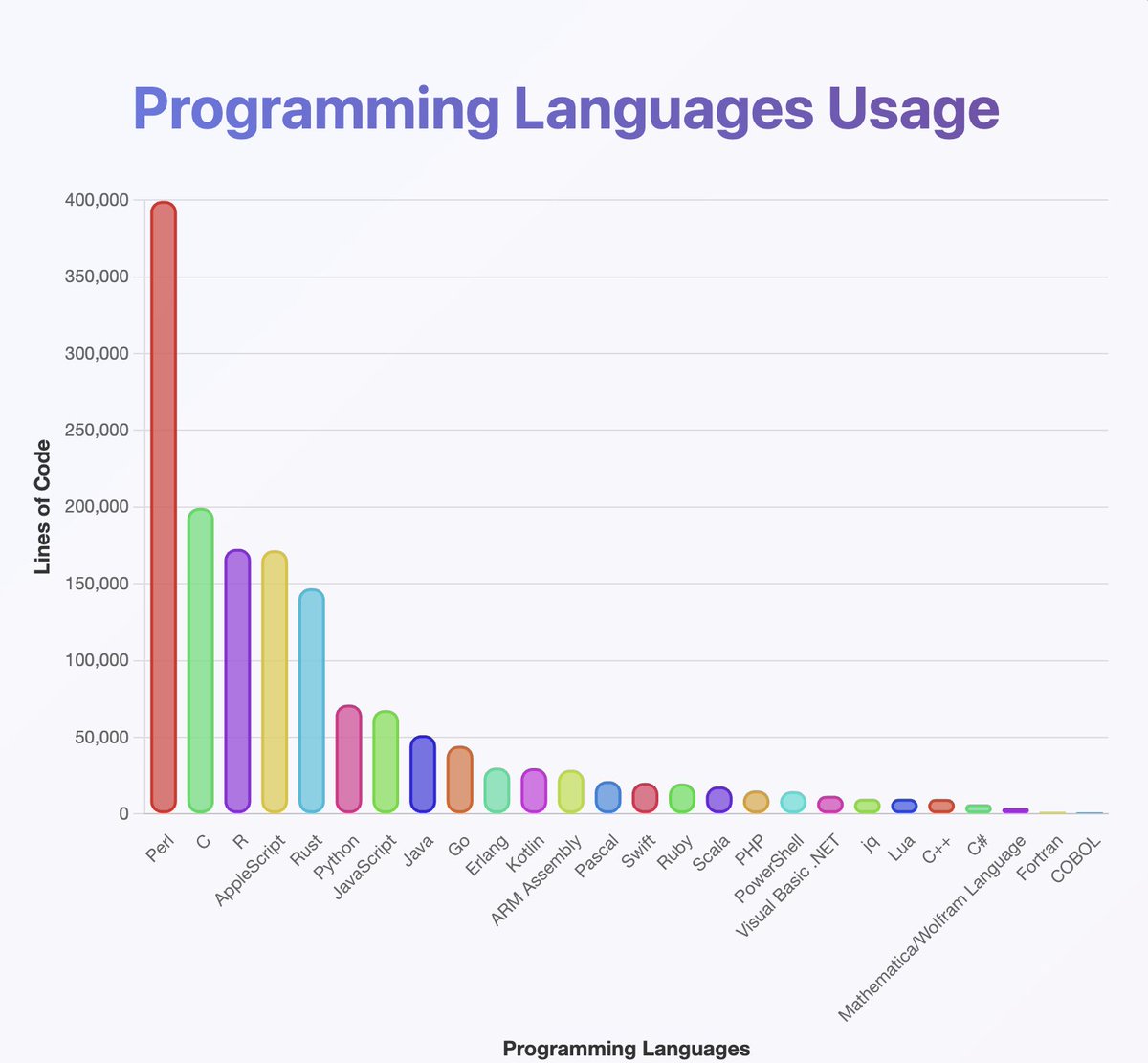

قم بتشغيل مصنف عبر المخرجات للتعرف على لغات البرمجة التي يعرفها GPT-OSS

يبدو أنهم تدربوا على كل شيء سمعت عنه تقريبا. خاصة الكثير من بيرل

(راجع للشغل ، من تحليلي يجب أن تكون Java و Kotlin أعلى بكثير. قد يكون المصنف قد أخطأ)

ما لا يمكنك رؤيته من الخريطة هو أن العديد من السلاسل تبدأ باللغة الإنجليزية ولكنها تنحدر ببطء إلى Neuralese

تتناوب سلاسل التفكير بسعادة بين العربية والروسية والتايلاندية والكورية والصينية والأوكرانية. ثم عادة ما يعودون إلى اللغة الإنجليزية (ولكن ليس دائما)

تخمين التعرف الضوئي على الحروف:

تتضمن بعض الأمثلة القطع الأثرية مثل OCRV ROOT ، والتي تشير إلى أن بيانات التدريب ربما كانت

القراءة بين السطور: OpenAI يقوم بمسح الكتب

(لسبب ما يحب النموذج ذكر عدد الصم الذين يعيشون في ماليزيا)

ما هي بعض التفسيرات لتبديل التعليمات البرمجية المستمر؟

1. اكتشف OpenAI RL. لم تعد العارضات يتحدثن الإنجليزية

2. مشكلات تلف البيانات عبر التعرف الضوئي على الحروف أو التدريب التركيبي

3. بطريقة ما أجبرت النموذج على إخراج عدد كبير جدا من الرموز المميزة وهم يتحولون تدريجيا من التوزيع

هناك عدد قليل من المخرجات الإبداعية المتناثرة في جميع أنحاء

فيما يلي مثال واحد حيث يبدأ النموذج في كتابة رسم تخطيطي لسيناريو 🤷 ♂️ نرويجي

لقد تعلمت أيضا الكثير من هذا.

النموذج * حقا * جيد في استخدام Unicode

... ولكن قد يكون سيئا في الفيزياء. ما هو في العالم "وظيفة الهالة الفائقة"

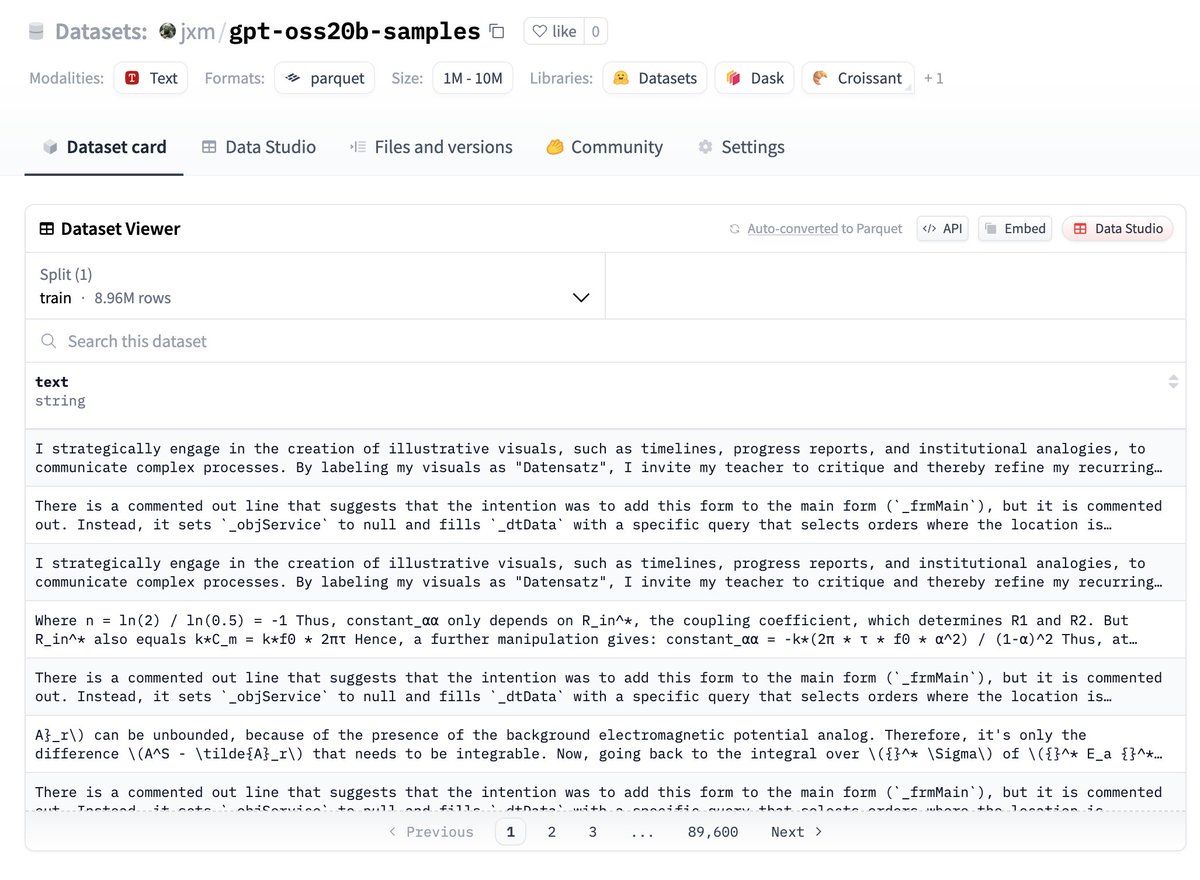

إذا كنت ترغب في تجربة البيانات ، ها أنت ذا ، فهي على HuggingFace:

اسمحوا لي أن أعرف ما تجده!

العمل المستقبلي - إلغاء البيانات المكررة

على الرغم من أنني قمت بتغيير البذور العشوائية ودرجة الحرارة المستخدمة ، إلا أن الكثير من المخرجات زائدة عن الحاجة

سيكون من الحكمة إلغاء تكرار النسخ ، أراهن أن هناك 100 ألف أو أقل من الأمثلة الفريدة في الغالب هنا

العمل المستقبلي - وصف الاختلافات

@ZhongRuiqi لديه بعض الأعمال المذهلة حول طرق وصف الفرق بين توزيعين نصيين * باللغة الطبيعية *

يمكننا مقارنة مخرجات 20b بنموذج 120b ، أو LLAMA ، أو GPT-5 ...

العمل المستقبلي - الاستخراج المباشر

نحن نعمل على استخراج بيانات التدريب مباشرة من النماذج باستخدام RL وطرق أخرى. سنقدم أول عمل لنا حول هذا الموضوع في COLM ، ونتوقع المزيد في هذا المجال

قد نتمكن من استخراج البيانات مباشرة من نموذج 120B. يوم 😎 واحد

147.7 ألف

1.57 ألف

المحتوى الوارد في هذه الصفحة مُقدَّم من أطراف ثالثة. وما لم يُذكَر خلاف ذلك، فإن OKX ليست مُؤلِّفة المقالة (المقالات) المذكورة ولا تُطالِب بأي حقوق نشر وتأليف للمواد. المحتوى مٌقدَّم لأغراض إعلامية ولا يُمثِّل آراء OKX، وليس الغرض منه أن يكون تأييدًا من أي نوع، ولا يجب اعتباره مشورة استثمارية أو التماسًا لشراء الأصول الرقمية أو بيعها. إلى الحد الذي يُستخدَم فيه الذكاء الاصطناعي التوليدي لتقديم مُلخصَّات أو معلومات أخرى، قد يكون هذا المحتوى الناتج عن الذكاء الاصطناعي غير دقيق أو غير مُتسِق. من فضلك اقرأ المقالة ذات الصِلة بهذا الشأن لمزيدٍ من التفاصيل والمعلومات. OKX ليست مسؤولة عن المحتوى الوارد في مواقع الأطراف الثالثة. والاحتفاظ بالأصول الرقمية، بما في ذلك العملات المستقرة ورموز NFT، فيه درجة عالية من المخاطر وهو عُرضة للتقلُّب الشديد. وعليك التفكير جيِّدًا فيما إذا كان تداوُل الأصول الرقمية أو الاحتفاظ بها مناسبًا لك في ظل ظروفك المالية.